- Brief Table of Contents (Not Yet Final)

- 1. Fundamentals of Events and Event Streams

- What’s an Event?

- What’s an Event Stream?

- The Structure of an Event

- Aggregating State from Keyed Events

- Materializing State from Entity Events

- Deleting Events and Event Stream Compaction

- The Kappa Architecture

- The Lambda Architecture

- Event Data Definitions and Schemas

- Powering Microservices with the Event Broker

- Selecting an Event Broker

- Summary

- 2. Fundamentals of Event-Driven Microservices

- 3. Designing Events

- 4. Integrating Event-Driven Architectures with Existing Systems

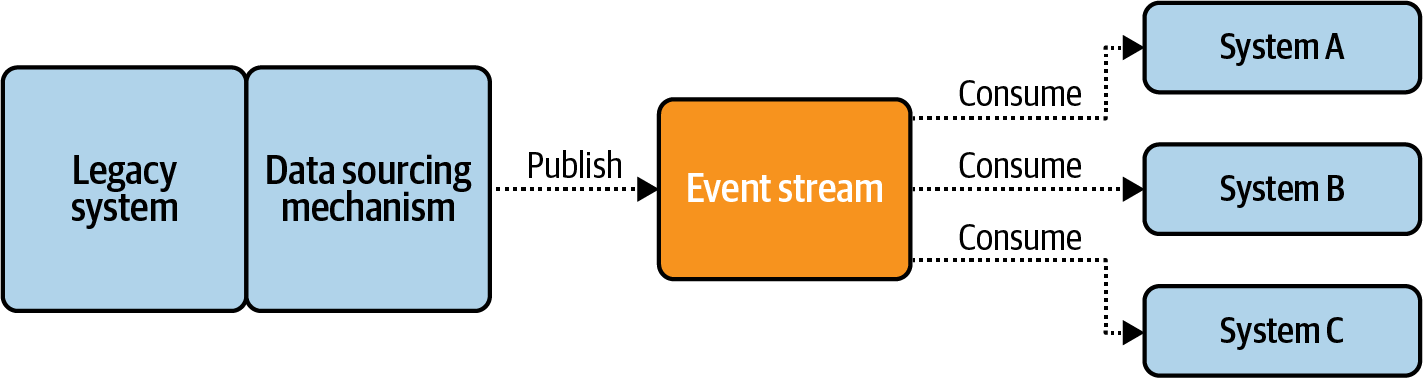

- What Is Data Liberation?

- Data Liberation Patterns

- Data Liberation Frameworks

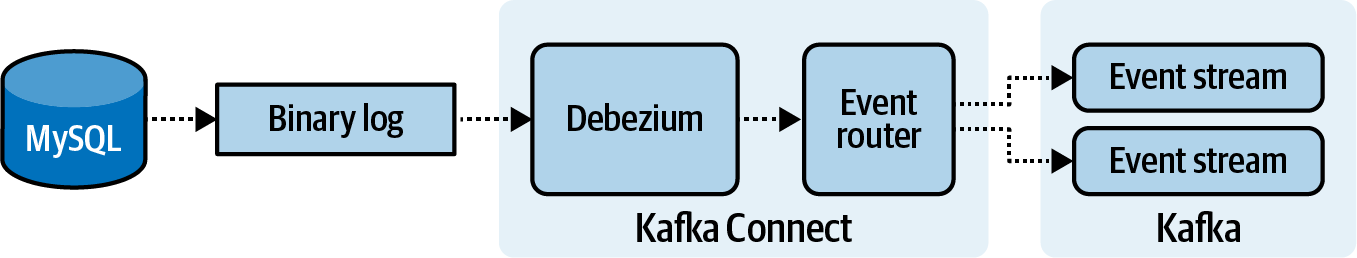

- Liberating Data Using Change-Data Capture

- Liberating Data with a Polling Query

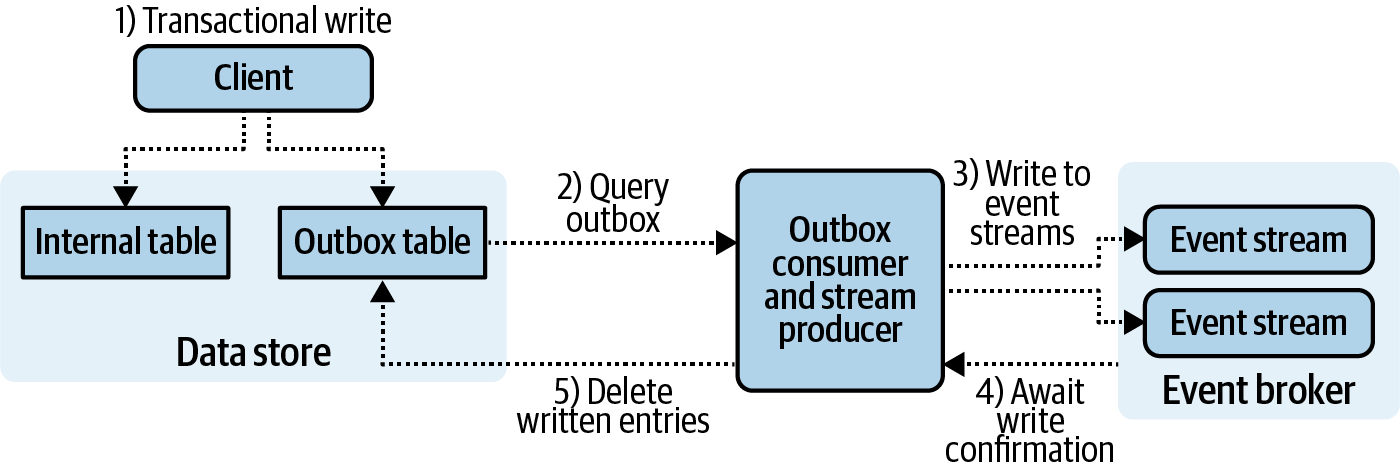

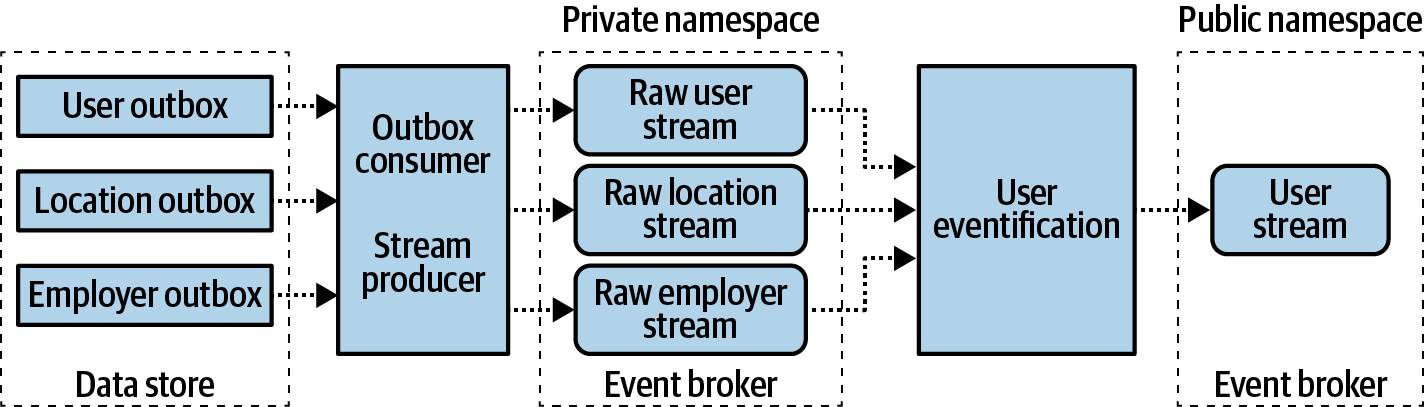

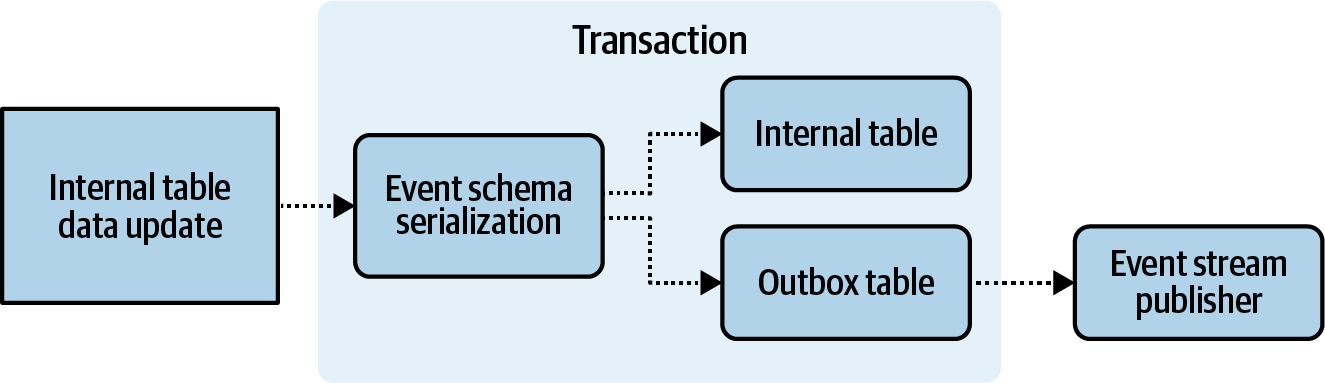

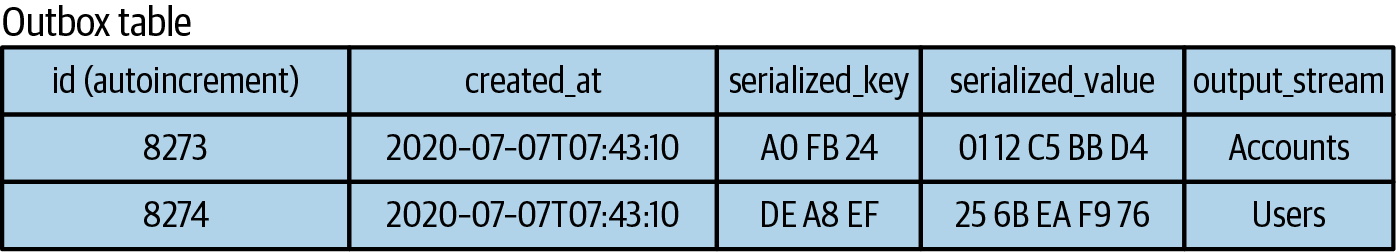

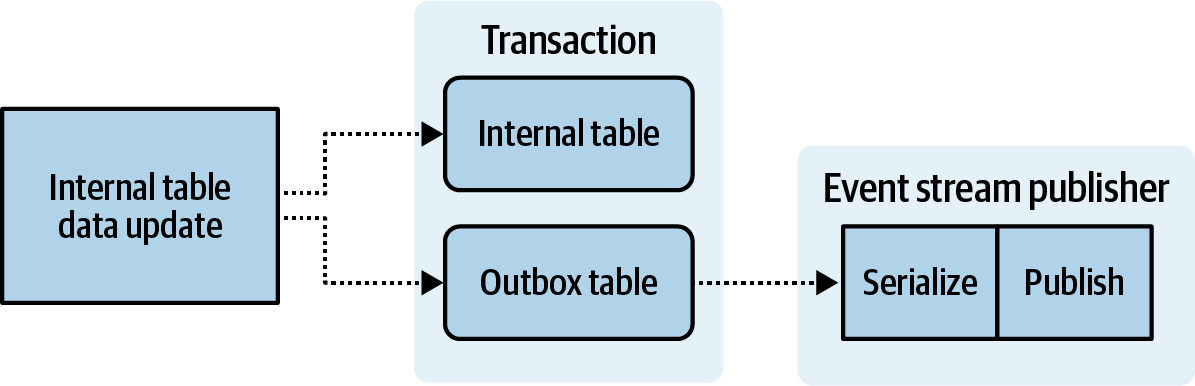

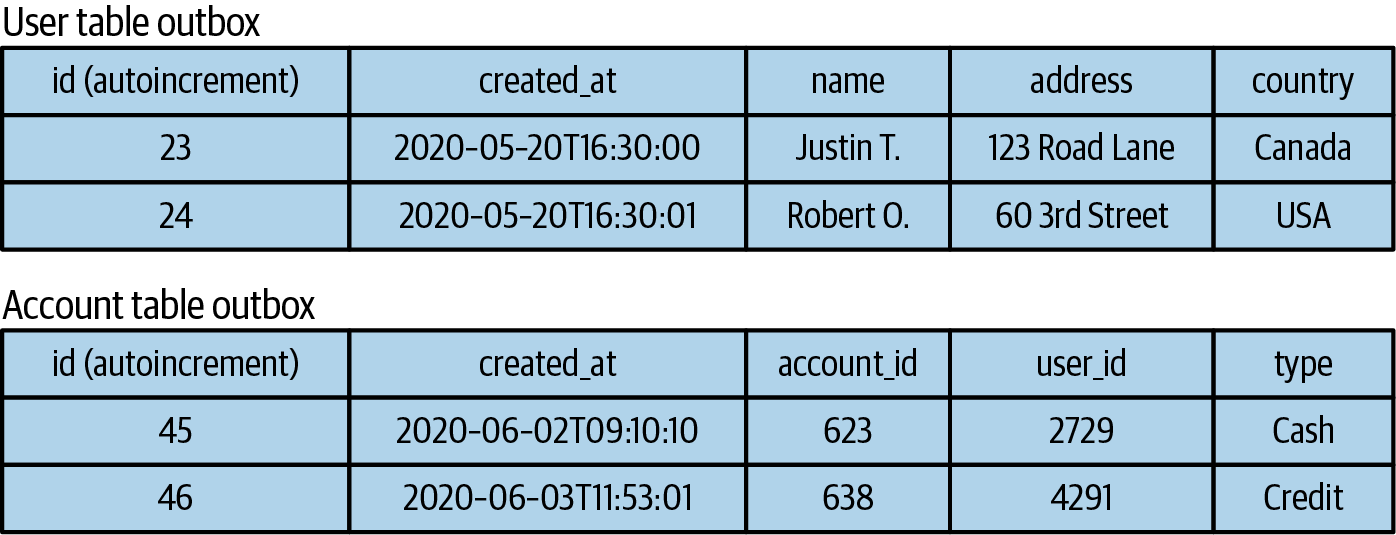

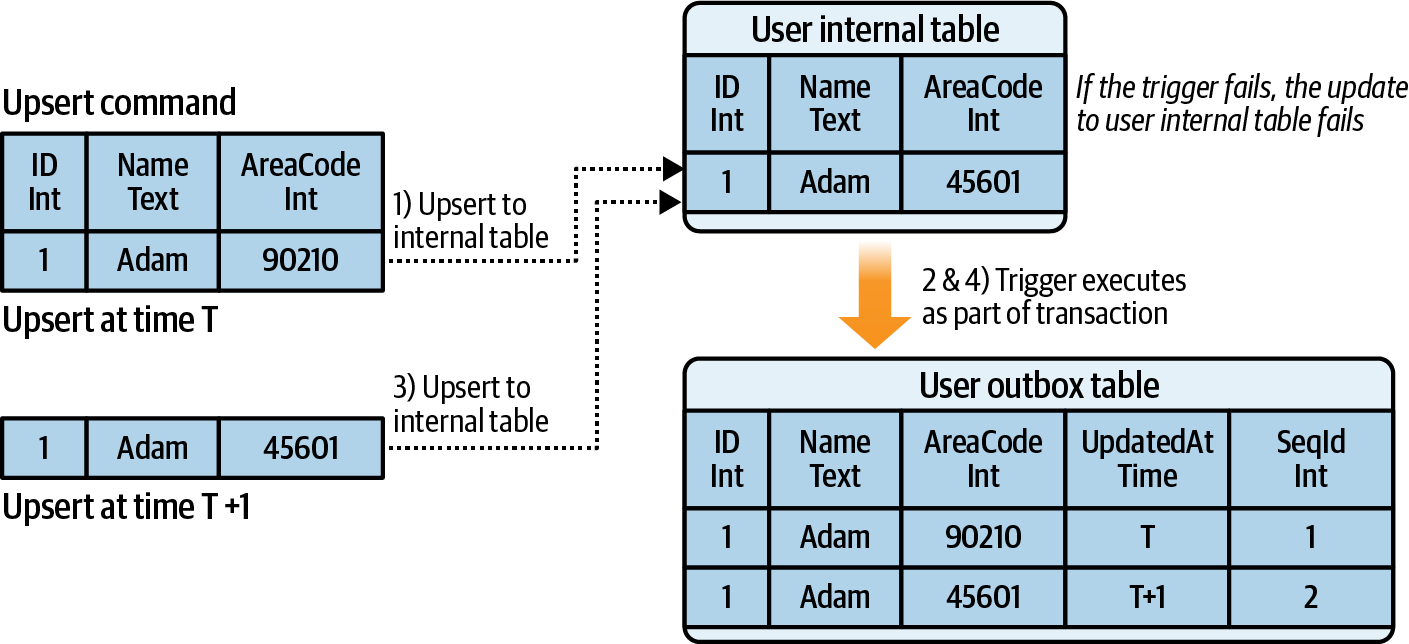

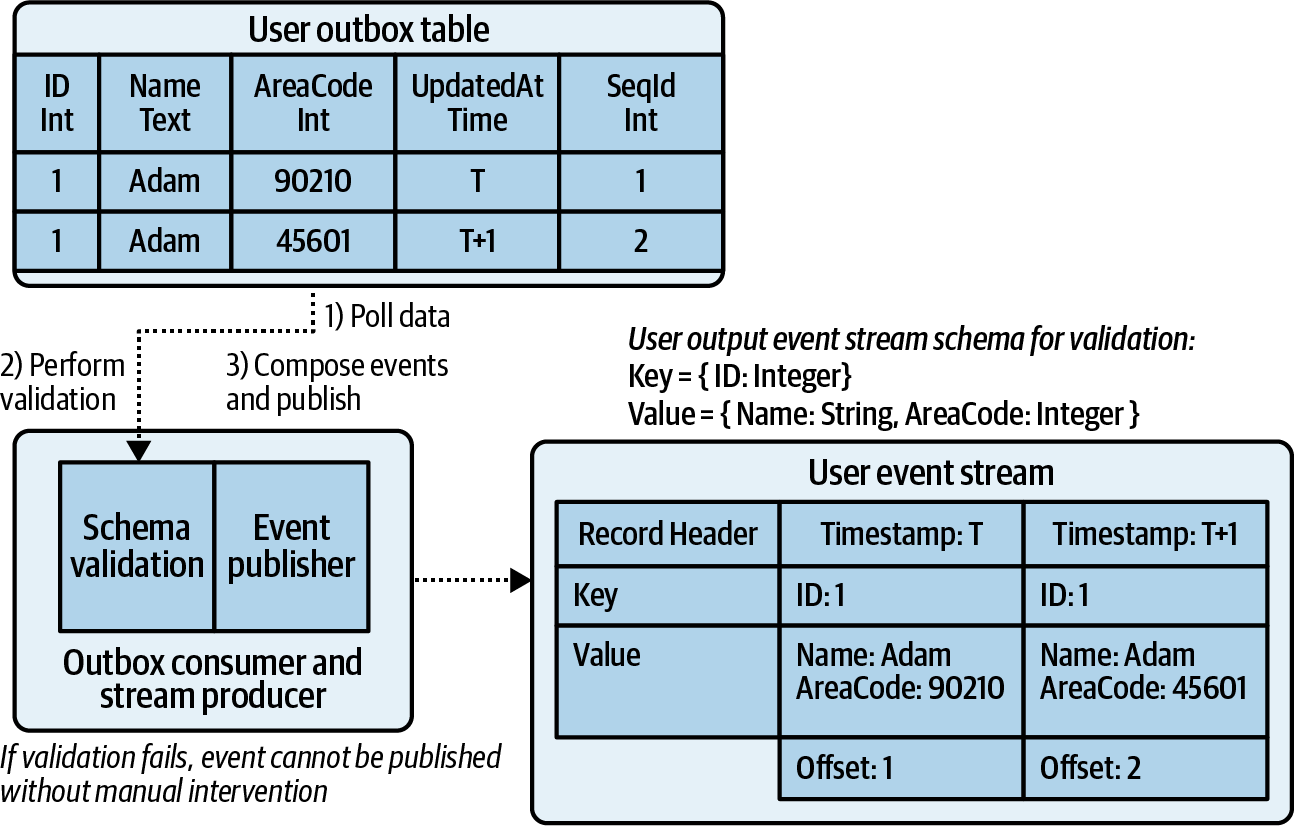

- Liberating Data Using Transactional Outbox Tables

- Making Data Definition Changes to Data Sets Under Capture

- Sinking Event Data to Data Stores

- The Impacts of Sinking and Sourcing on a Business

- Summary

Building Event-Driven Microservices

"Tận dụng Dữ liệu Tổ chức ở Quy mô Lớn"

Adam Bellemare

Building Event-Driven Microservices

bởi Adam Bellemare

Bản quyền © 2025 Adam Bellemare. Tất cả các quyền được bảo lưu.

In Ấn Độ Hoa Kỳ.

Xuất bản bởi O'Reilly Media, Inc., 1005 Gravenstein Highway Bắc, Sebastopol, CA 95472.

Sách O'Reilly có thể được mua cho mục đích giáo dục, kinh doanh hoặc khuyến mãi bán hàng. Phiên bản trực tuyến cũng có sẵn cho hầu hết các tựa sách (http://oreilly.com). Để biết thêm thông tin, hãy liên hệ với bộ phận bán hàng doanh nghiệp/cơ quan của chúng tôi: 800-998-9938 hoặc corporate@oreilly.com.

- Acquisitions Editor: Melissa Duffield

- Development Editor: Corbin Collins

- Production Editor: Clare Laylock

- Interior Designer: David Futato

- Cover Designer: Karen Montgomery

- Illustrator: Kate Dullea

- August 2020: First Edition

- September 2025: Second Edition

Revision History for the Early Release

- 2025-02-19: First Release

Xem http://oreilly.com/catalog/errata.csp?isbn=9781492057895 để biết chi tiết về phiên bản.

Logo O’Reilly là thương hiệu đã được đăng ký của O’Reilly Media, Inc. Xây dựng Microservices theo sự kiện, hình ảnh bìa và liên quan là thương hiệu của O’Reilly Media, Inc.

Ý kiến được trình bày trong tác phẩm này là của tác giả, và không đại diện cho quan điểm của nhà xuất bản. Mặc dù nhà xuất bản và tác giả đã nỗ lực tốt để đảm bảo rằng thông tin và hướng dẫn trong tác phẩm này là chính xác, nhà xuất bản và tác giả từ chối tất cả trách nhiệm đối với các sai sót hoặc thiếu sót, bao gồm cả trách nhiệm không giới hạn đối với thiệt hại phát sinh từ việc sử dụng hoặc tin tưởng vào tác phẩm này. Việc sử dụng thông tin và hướng dẫn trong tác phẩm này hoàn toàn do bạn tự quyết. Nếu bất kỳ mẫu mã hoặc công nghệ nào mà tác phẩm này chứa hoặc mô tả chịu sự điều chỉnh của các giấy phép mã nguồn mở hoặc quyền sở hữu trí tuệ của người khác, bạn có trách nhiệm đảm bảo rằng việc sử dụng chúng tuân thủ các giấy phép và/hoặc quyền đó.

Công việc này là một phần của sự hợp tác giữa O'Reilly và Confluence. Xem tuyên bố về sự độc lập biên tập của chúng tôi.

Chín bảy chín - tám - ba bốn một - sáu hai hai một - hai

[LSI]

Brief Table of Contents (Not Yet Final)

Lời giới thiệu (không có sẵn)

Chương 1. Tại sao lại là Microservices theo sự kiện? (không có sẵn)

Chương 2. Những nguyên tắc cơ bản về Sự kiện và Truyền phát Sự kiện

Chương 3. Các nguyên tắc cơ bản của Microservices theo sự kiện

Chương 4. Các sơ đồ và hợp đồng dữ liệu (không khả dụng)

Chương 5. Thiết kế Sự kiện

Chương 6. Tích hợp Kiến trúc Theo Sự kiện với các Hệ thống Hiện có

Chương 7. Sự kiện hóa và Hạ chuẩn (không có sẵn)

Chương 8. Xử lý luồng xác định (không có sẵn)

Chương 9. Streaming có trạng thái (không có sẵn)

Chương 10. Xây dựng Quy trình làm việc với Microservices (không có sẵn)

Chương 11. Tính nhất quán cuối cùng và hội tụ (không có sẵn)

Chương 12. Các dịch vụ vi mô nhà sản xuất và người tiêu dùng cơ bản (không có sẵn)

Chương 13. Microservices Sử dụng Function-as-a-Service (không có sẵn)

Chương 14. Microservices Khung Nặng (không khả dụng)

Chương 15. Khung Thực Thi Bền Vững (không có sẵn)

Chương 16. Microservices Khung Nhẹ (không có sẵn)

Chương 17. Truy vấn SQL trực tuyến dưới dạng dịch vụ vi mô (không có sẵn)

Chương 18. Tích hợp các dịch vụ vi mô kiểu sự kiện và kiểu yêu cầu - phản hồi (không có sẵn)

Chương 19. Trải nghiệm người dùng hướng đến sự kiện (không khả dụng)

Chương 20. Công cụ hỗ trợ (không có sẵn)

Chương 21. Kiểm tra Microservices Dựa trên Sự Kiện (không khả dụng)

Chương 22. Triển khai Microservices Dựa trên Sự Kiện (không có sẵn)

Chương 23. Kết luận (không có sẵn)

Chapter 1. Fundamentals of Events and Event Streams

Các luồng sự kiện được phục vụ bởi một trung gian sự kiện thường là chế độ chủ yếu cho các kiến trúc hướng sự kiện mạnh mẽ, tuy nhiên bạn sẽ thấy rằng hàng đợi và nhắn tin tạm thời cũng có vị trí của chúng. Chúng ta sẽ đề cập đến từng chế độ này một cách chi tiết hơn trong nửa sau của chương này.

Hiện tại, hãy cùng nhau xem xét kỹ lưỡng các sự kiện, bản ghi và tin nhắn, cũng như mối quan hệ giữa luồng sự kiện và trung gian sự kiện.

What’s an Event?

Một sự kiện có thể là bất cứ điều gì đã xảy ra trong khuôn khổ của cấu trúc giao tiếp kinh doanh. Nhận hóa đơn, đặt phòng họp, yêu cầu một cốc cà phê (vâng, bạn có thể kết nối một máy pha cà phê với một luồng sự kiện), tuyển dụng một nhân viên mới và hoàn thành thành công mã tùy ý đều là những ví dụ về các sự kiện xảy ra trong một doanh nghiệp. Điều quan trọng là nhận ra rằng các sự kiện có thể là bất cứ điều gì quan trọng đối với doanh nghiệp. Khi những sự kiện này bắt đầu được ghi lại, các hệ thống dựa trên sự kiện có thể được tạo ra để khai thác và sử dụng chúng trong toàn tổ chức.

Một sự kiện là một bản ghi lại những gì đã diễn ra, tương tự như cách mà thông tin và nhật ký lỗi của một ứng dụng ghi lại những gì xảy ra trong ứng dụng đó. Tuy nhiên, khác với những nhật ký này, sự kiện cũng là nguồn thông tin chính xác duy nhất, như đã đề cập trong [Liên kết sẽ đến sau]. Do đó, chúng phải chứa tất cả thông tin cần thiết để mô tả chính xác những gì đã xảy ra.

Các sự kiện sử dụng các lược đồ, điều này được trình bày chi tiết hơn trong [Liên kết sẽ có sau]. Hiện tại, hãy xem xét rằng các sự kiện có tên trường, kiểu dữ liệu và giá trị mặc định được xác định rõ ràng.

Tôi tránh sử dụng thuật ngữ "thông điệp" khi thảo luận về các dòng sự kiện và kiến trúc dựa trên sự kiện. Đó là một thuật ngữ có nhiều ý nghĩa khác nhau đối với từng người, và cũng bị ảnh hưởng mạnh mẽ bởi công nghệ bạn đang sử dụng. Hãy nghĩ về ý nghĩa của các thông điệp trong cuộc sống hàng ngày của chúng ta, đặc biệt nếu bạn sử dụng tin nhắn ngay lập tức. Một người gửi một thông điệp đến một người cụ thể hoặc đến một nhóm riêng tư cụ thể. Ngoài ra, các thông điệp có thể hoặc không thể bền vững - một số ứng dụng trò chuyện xóa các thông điệp sau khi đọc, trong khi những ứng dụng khác xóa sau một khoảng thời gian nhất định.

Sự kiện trong kiến trúc hướng sự kiện tương tự như một bài đăng mà bạn công bố trên một nền tảng mạng xã hội hoặc bảng tin. Bài đăng là công khai với tất cả mọi người, và mọi người đều có thể tự do đọc nó và sử dụng nó theo cách mà họ muốn. Nhiều người có thể đọc bài đăng, và tất nhiên bài đăng có thể được đọc đi đọc lại nhiều lần. Nó sẽ không bị xóa chỉ vì nó đã cũ. Dòng sự kiện thực chất là một buổi phát sóng để chia sẻ dữ liệu quan trọng, cho phép người khác đăng ký nhận thông tin và sử dụng nó theo cách họ thấy phù hợp.

Chỉ để rõ ràng, bạn có thể sử dụng luồng sự kiện để gửi tin nhắn. Tất cả các tin nhắn là sự kiện, nhưng không phải tất cả các sự kiện đều là tin nhắn. Nhưng để rõ ràng hơn, tôi sẽ sử dụng các thuật ngữ sự kiện và bản ghi thay vì tin nhắn cho những chương còn lại của cuốn sách này. Nhưng trước khi chúng ta đào sâu vào các sự kiện, hãy cùng nhìn qua một chút về luồng sự kiện.

What’s an Event Stream?

Một luồng sự kiện là một nhật ký bền vững và chỉ thêm, không thay đổi. Các bản ghi được thêm vào cuối nhật ký (đuôi) khi chúng được xuất bản bởi nhà sản xuất. Người tiêu dùng bắt đầu từ đầu nhật ký (đầu) và tiêu thụ các bản ghi với tốc độ xử lý của riêng họ.

Dưới hình thức cơ bản nhất, một luồng sự kiện là một chuỗi các sự kiện kinh doanh được đánh dấu thời gian liên quan đến một miền. Các sự kiện tạo thành cơ sở để giao tiếp dữ liệu kinh doanh quan trọng giữa các miền một cách đáng tin cậy và lặp đi lặp lại.

"Stream sự kiện có một số thuộc tính quan trọng cho phép chúng ta tin tưởng vào chúng cho các microservices hướng sự kiện, và như một cơ sở cho việc giao tiếp dữ liệu hiệu quả giữa các miền nói chung. Để rõ ràng, và với một chút lặp lại, các thuộc tính này bao gồm:"

- Immutability

-

Các sự kiện không thể được sửa đổi sau khi đã ghi vào nhật ký. Nội dung không thể bị thay đổi, cũng như vị trí bù, dấu thời gian hoặc bất kỳ siêu dữ liệu nào khác liên quan. Bạn chỉ có thể thêm các sự kiện mới.

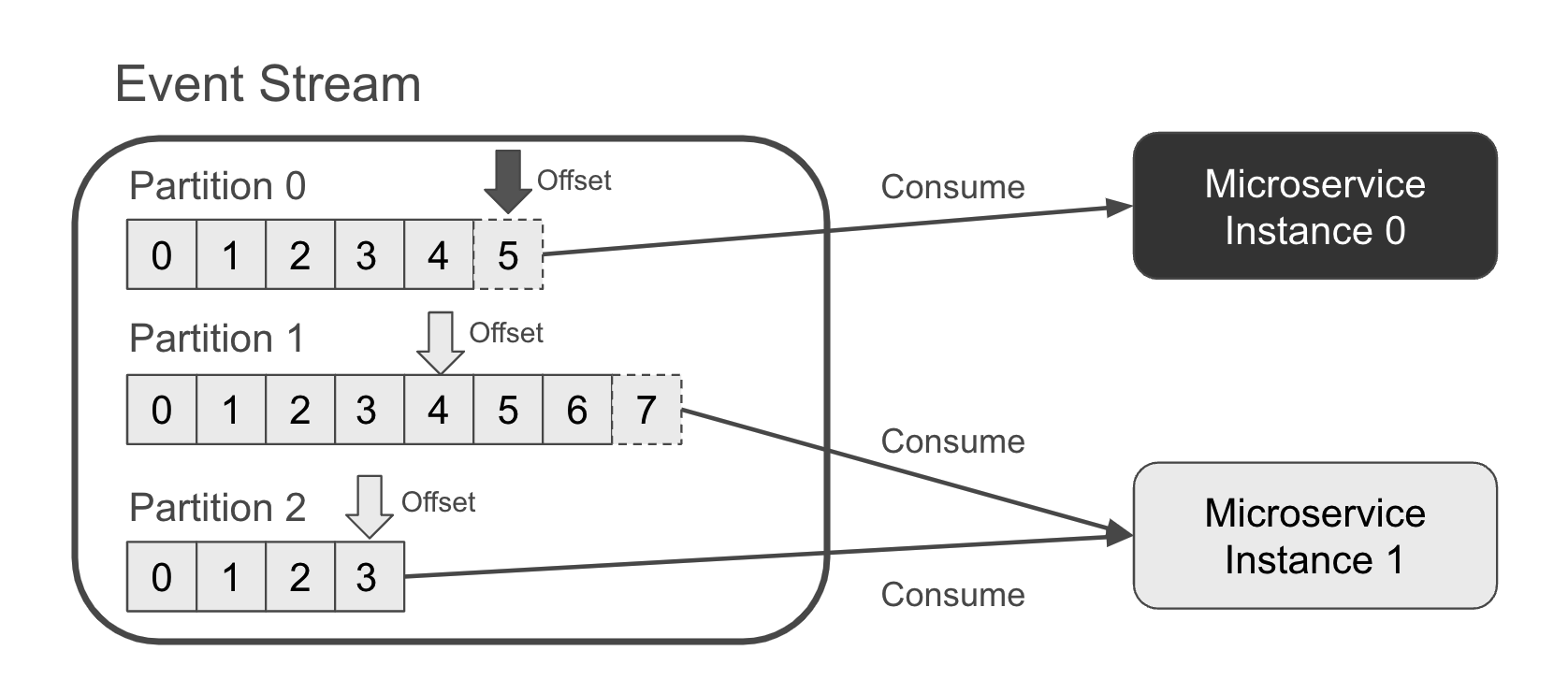

- Partition Support

-

Các phân vùng cung cấp phương tiện để hỗ trợ các tập dữ liệu khổng lồ. Một người tiêu dùng có thể đăng ký một hoặc nhiều phân vùng từ một luồng sự kiện duy nhất, cho phép nhiều phiên bản của một dịch vụ vi mô tiêu thụ và xử lý luồng đó một cách song song.

- Indexed

-

Sự kiện được gán một chỉ mục không thể thay đổi khi được ghi vào nhật ký. Chỉ mục, thường được gọi là độ dịch, xác định duy nhất sự kiện.

- Strictly Ordered

-

Các bản ghi trong một phân vùng luồng sự kiện được phục vụ cho các khách hàng theo đúng thứ tự mà chúng được phát hành ban đầu.

- Durability and replayability

-

Các sự kiện là bền vững. Chúng có thể được tiêu thụ ngay lập tức hoặc trong tương lai. Các sự kiện có thể được phát lại bởi cả người tiêu dùng mới và hiện tại, miễn là môi giới sự kiện có đủ dung lượng lưu trữ để lưu giữ dữ liệu lịch sử. Các sự kiện không bị xóa sau khi được đọc, cũng như không bị loại bỏ đơn giản trong trường hợp không có người tiêu dùng.

- Indefinite Storage Support

-

Bạn có thể giữ lại tất cả các sự kiện trong luồng của mình lâu bất cứ khi nào cần thiết. Không có thời gian hết hiệu lực bắt buộc hay giới hạn thời gian lưu giữ, cho phép bạn tiêu thụ và tiêu thụ lại các sự kiện nhiều lần như bạn cần.

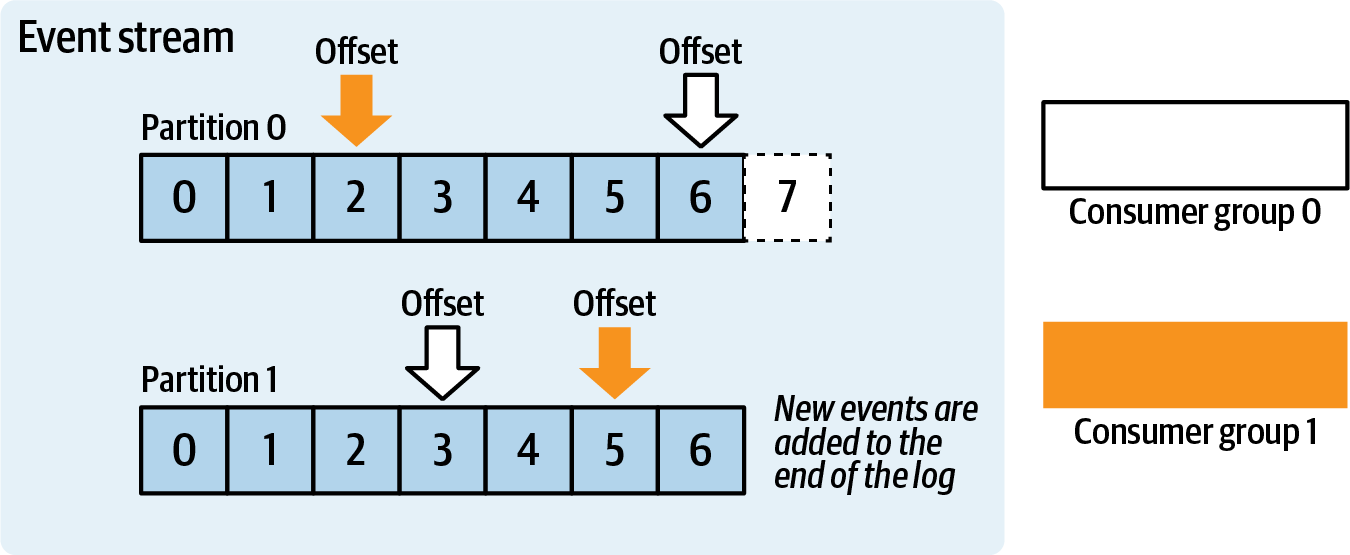

Hình 1-1 cho thấy một luồng sự kiện với ba phân vùng. Các sự kiện mới vừa được thêm vào phân vùng 0 (điểm bù 5) và phân vùng 1 (điểm bù 7). Microservice tiêu thụ các sự kiện này có hai phiên bản. Phiên bản 0 chỉ tiêu thụ phân vùng 0, trong khi phiên bản 1 tiêu thụ cả phân vùng 1 và phân vùng 2.

Figure 1-1. An event stream with two microservice instances consuming from a three partitions

With sufficient processing power, the consuming service will remain up to date with the event stream. Meanwhile, a new consumer beginning at an earlier offset (or the head) will need to process all of the events to catch up to current time.

Các luồng sự kiện được lưu trữ trên một trình môi giới sự kiện, với một trong những lựa chọn phổ biến nhất (và trở thành tiêu chuẩn de-facto) là Apache Kafka. Trình môi giới sự kiện, chẳng hạn như trong trường hợp của Kafka, cung cấp một cấu trúc được gọi là chủ đề mà chúng ta có thể ghi lại các sự kiện của mình. Nó cũng xử lý mọi thứ từ sao chép dữ liệu và cân bằng lại đến kết nối khách hàng và kiểm soát quyền truy cập. Các nhà phát hành ghi các sự kiện vào luồng sự kiện được lưu trữ trong trình môi giới, trong khi các nhà tiêu thụ đăng ký các luồng sự kiện và nhận các sự kiện.

Rất tiếc, do một lịch sử dài và thường rối rắm, các trình môi giới sự kiện thường bị nhầm lẫn với tin nhắn tạm thời và hàng đợi. Mỗi tùy chọn này đều khác nhau. Hãy cùng xem xét kỹ lưỡng từng loại và lý do tại sao luồng sự kiện tạo thành nền tảng của kiến trúc hướng sự kiện hiện đại.

Ephemeral Messaging

Một kênh là một nền tảng tạm thời để truyền tải thông điệp giữa một nhà sản xuất và một hoặc nhiều người đăng ký. Các thông điệp được gửi đến những người tiêu thụ cụ thể, và chúng không được lưu lại trong một khoảng thời gian đáng kể, cũng như không được ghi vào bộ lưu trữ lâu dài bởi môi giới. Trong trường hợp hệ thống gặp sự cố hoặc thiếu người đăng ký trên kênh, các thông điệp sẽ đơn giản bị loại bỏ, cung cấp việc giao hàng tối đa một lần. NATS.io Core (không phải JetStream) là một ví dụ cho hình thức triển khai này.

Hình 1-2 cho thấy một nhà sản xuất duy nhất gửi tin nhắn đến kênh tạm thời trong bộ trung gian sự kiện. Các tin nhắn tạm thời sau đó được chuyển đến các người tiêu dùng hiện đang đăng ký. Trong hình này, Người tiêu dùng 0 nhận được tin nhắn 7 và 8, nhưng Người tiêu dùng 1 không nhận được vì họ mới đăng ký và không có quyền truy cập vào dữ liệu lịch sử. Thay vào đó, Người tiêu dùng 1 sẽ chỉ nhận được tin nhắn 9 và bất kỳ tin nhắn nào tiếp theo.

Figure 1-2. An ephemeral message-passing broker forwarding messages

Giao tiếp tạm thời rất phù hợp cho việc giao tiếp trực tiếp giữa các dịch vụ với chi phí thấp. Đây là một kiến trúc truyền tin, và không nên nhầm lẫn với kiến trúc phát hành-đăng ký bền vững như được cung cấp bởi các luồng sự kiện.

Kiến trúc truyền tin cung cấp giao tiếp điểm-điểm giữa các hệ thống mà không nhất thiết phải đảm bảo giao hàng ít nhất một lần và có thể chịu đựng một số mất dữ liệu. Ví dụ, ứng dụng hẹn hò trực tuyến Tinder sử dụng NATS để thông báo cho người dùng về các cập nhật. Nếu tin nhắn không được nhận, điều đó không quá nghiêm trọng—một thông báo đẩy bị bỏ lỡ chỉ có tác động nhỏ (mặc dù tiêu cực) đến trải nghiệm của người dùng.

Các trung gian truyền tin tạm thời thiếu khả năng lưu giữ vô thời hạn, độ bền và khả năng phát lại sự kiện cần thiết mà chúng tôi cần để xây dựng các sản phẩm dữ liệu dựa trên sự kiện. Kiến trúc truyền tin hữu ích cho việc giao tiếp dựa trên sự kiện giữa các hệ thống phục vụ mục đích vận hành hiện tại nhưng hoàn toàn không phù hợp để cung cấp phương tiện giao tiếp cho các sản phẩm dữ liệu.

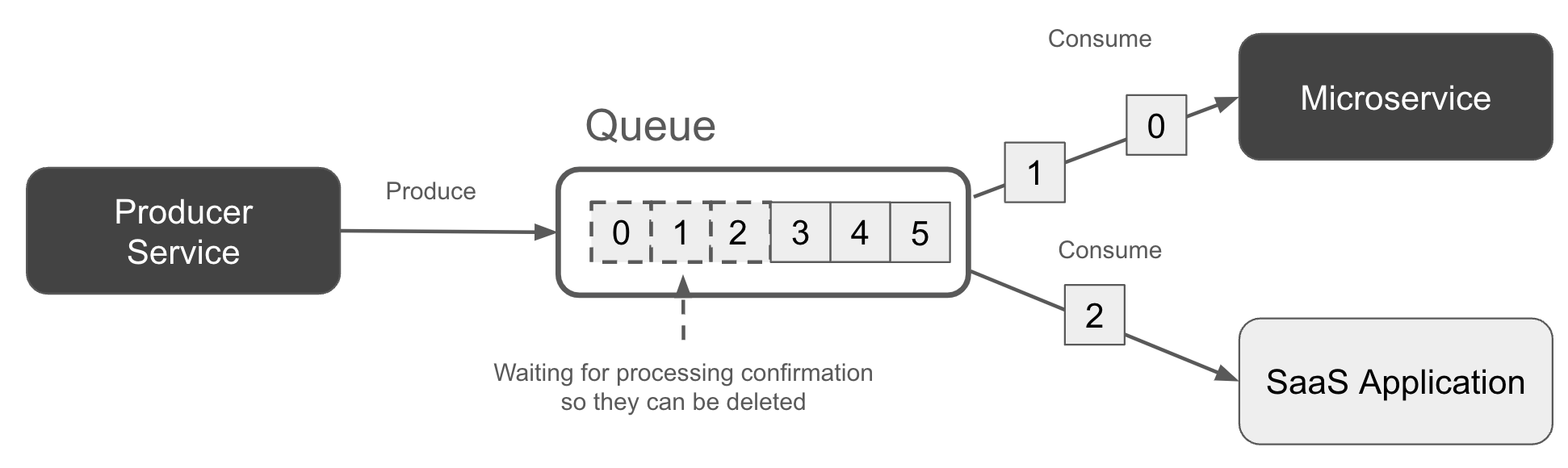

Queuing

Một hàng đợi là một chuỗi bền vững của các bản ghi được lưu trữ đang chờ được xử lý. Thông thường có nhiều người tiêu thụ đồng thời (và cạnh tranh) chọn, xử lý và xác nhận các bản ghi theo thứ tự ai đến trước được phục vụ trước. Đây là một trong những sự khác biệt chính khi so với các luồng sự kiện, sử dụng các đăng ký độc quyền phân vùng và xử lý theo thứ tự nghiêm ngặt.

Hàng đợi công việc là một trường hợp sử dụng phổ biến. Nhà sản xuất xuất bản các bản ghi "công việc cần làm", trong khi các máy tiêu thụ lấy ra các bản ghi, xử lý chúng, rồi báo hiệu cho môi giới hàng đợi rằng công việc đã hoàn thành. Sau đó, môi giới thường xóa các bản ghi đã được xử lý, đây là sự khác biệt lớn thứ hai khi so sánh với luồng sự kiện, vì luồng này giữ lại các bản ghi miễn là được chỉ định (bao gồm cả vô thời hạn).

Hình 1-3 cho thấy hai người đăng ký tiêu thụ các bản ghi từ một hàng đợi theo cách vòng tròn. Lưu ý rằng hàng đợi chứa các bản ghi đang được xử lý (đường nét đứt) và những bản ghi chưa được xử lý (đường liền).

Figure 1-3. A queue with two subscribers each processing a subset of events

Hàng đợi thường cung cấp đảm bảo xử lý "ít nhất một lần". Các bản ghi có thể được xử lý nhiều hơn một lần, đặc biệt nếu một người đăng ký không cam kết tiến trình của mình trở lại với trung gian, chẳng hạn do bị treo, sau khi xử lý một bản ghi. Trong trường hợp này, một người đăng ký khác có thể lấy bản ghi và xử lý lại.

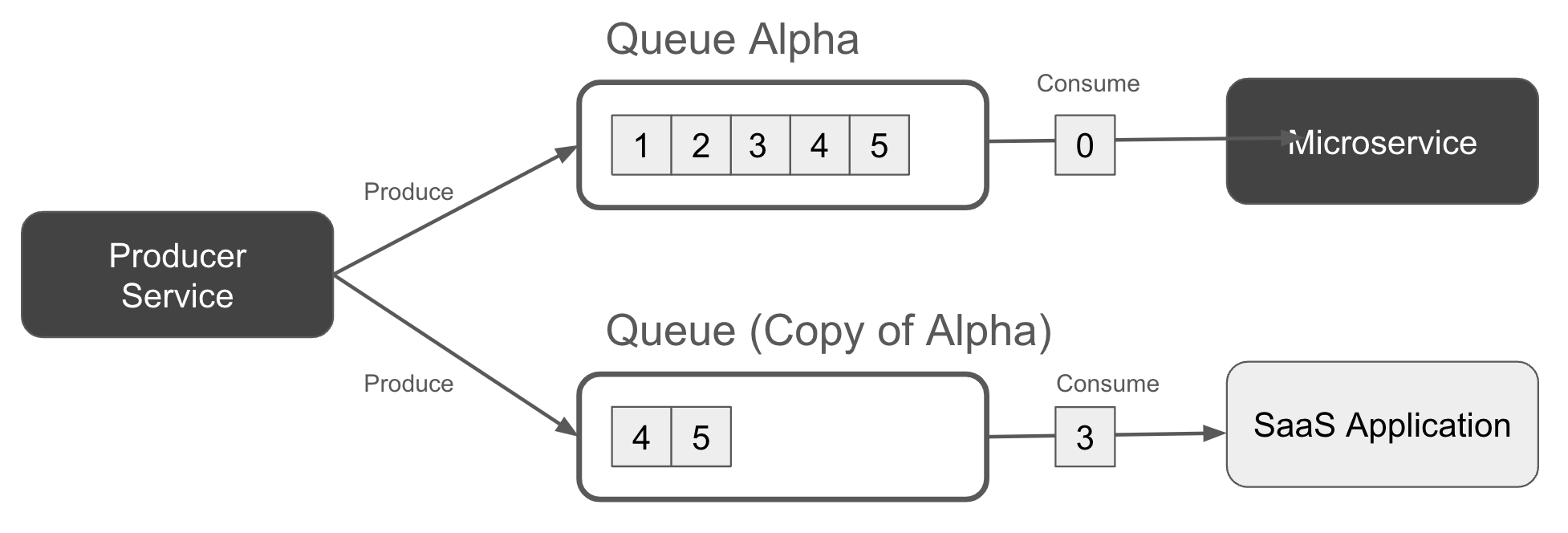

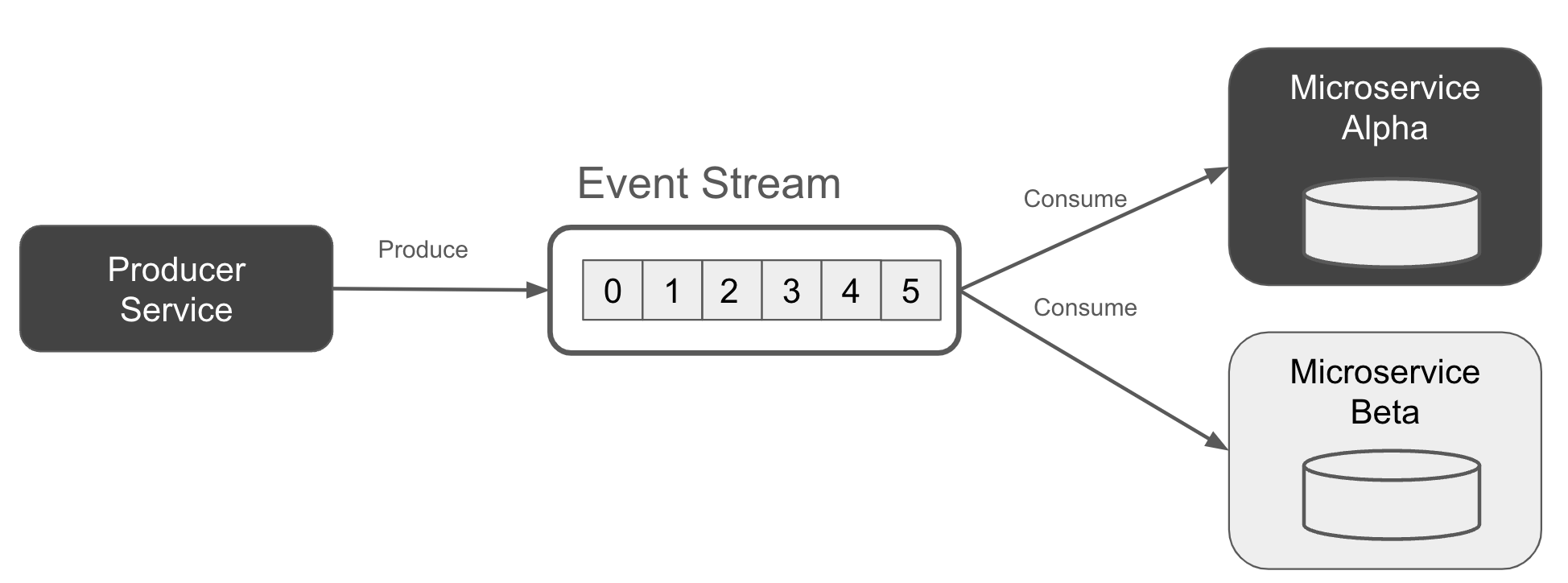

Nếu nhiều người tiêu dùng độc lập (ví dụ: các ứng dụng microservice) cần truy cập vào các bản ghi trong hàng đợi (chẳng hạn như để thực hiện một sự kiện Bán hàng), thì bạn phải sử dụng một dòng sự kiện hoặc tạo một hàng đợi cho mỗi dịch vụ tiêu thụ. Hình 1-4 cho thấy một ví dụ, trong đó dịch vụ sản xuất ghi một bản sao của mỗi bản ghi vào hai hàng đợi khác nhau để đảm bảo rằng mỗi người tiêu dùng có một bản sao của dữ liệu để xử lý.

Figure 1-4. A producer writing to two duplicate queues, one or each consumer application.

Warning

Dịch vụ sản xuất của bạn có thể không thể ghi đồng thời vào nhiều hàng đợi hơn một lần. Bạn sẽ cần xem xét các hạn chế của khả năng ghi vào nhiều hàng đợi của broker của bạn. Nếu không làm như vậy, các hàng đợi có thể phân kỳ với nhau theo thời gian, khi điều kiện cạnh tranh và các lỗi tạm thời có thể khiến một bản ghi được ghi vào một hàng đợi, nhưng không ghi vào các hàng đợi khác.

Lịch sử, các nhà môi giới hàng đợi đã giới hạn thời gian tồn tại (TTL) để lưu trữ các bản ghi trong hàng đợi. Các bản ghi không được xử lý trong một khoảng thời gian nhất định sẽ bị đánh dấu là chết, bị xóa đi và không còn được gửi đến các người nhận - ngay cả khi chúng chưa được xử lý! Tương tự như các giao tiếp tạm thời, việc giữ lại dựa trên thời gian và dữ liệu không thể phát lại đã ảnh hưởng đến nhận thức sai lầm rằng các nhà môi giới (cả hàng đợi và sự kiện) không thể được sử dụng để giữ dữ liệu vô thời hạn.

Với điều đó được nói ra, quan trọng là lưu ý rằng TTL thấp không còn là tiêu chuẩn nữa, ít nhất là đối với các công nghệ hàng đợi hiện đại hơn. Ví dụ, cả RabbitMQ và ActiveMQ đều cho phép bạn đặt TTL không hạn chế cho các bản ghi của bạn, cho phép bạn giữ chúng trong hàng đợi miễn là cần thiết cho doanh nghiệp của bạn.

Note

Các trung gian hàng đợi hiện đại cũng có thể hỗ trợ khả năng phát lại và lưu trữ vô hạn các bản ghi thông qua các nhật ký ghi đè bền vững - về cơ bản giống như một luồng sự kiện. Chẳng hạn, cả Solace và RabbitMQ Streams đều cho phép các người tiêu dùng riêng lẻ phát lại các bản ghi đã được xếp hàng như thể đó là một luồng sự kiện.

Một điều cuối cùng trước khi chúng ta kết thúc phần này. Hàng đợi cũng có thể cung cấp thứ tự ghi dựa trên ưu tiên cho người tiêu dùng, để các bản ghi ưu tiên cao được đẩy lên phía trước, trong khi các bản ghi ưu tiên thấp sẽ ở lại phía sau hàng đợi cho đến khi tất cả các bản ghi ưu tiên cao hơn được xử lý. Hàng đợi cung cấp một cấu trúc dữ liệu lý tưởng cho việc sắp xếp theo ưu tiên, vì chúng không áp dụng một thứ tự vào trước, ra trước nghiêm ngặt như một luồng sự kiện.

Hàng đợi được sử dụng tốt nhất như một bộ đệm đầu vào cho một hệ thống hạ nguồn cụ thể. Bạn có thể dựa vào một hàng đợi để lưu trữ các bản ghi cần được xử lý bởi một hệ thống khác, cho phép ứng dụng sản xuất tiếp tục với các nhiệm vụ khác - bao gồm việc ghi thêm các bản ghi vào hàng đợi. Bạn có thể tin tưởng vào hàng đợi để lưu trữ bền bỉ tất cả các bản ghi cho đến khi dịch vụ tiêu thụ của bạn có thể làm việc với chúng. Thêm vào đó, dịch vụ tiêu thụ của bạn có thể mở rộng quy mô xử lý bằng cách đăng ký thêm các người tiêu dùng mới trên hàng đợi và chia sẻ việc xử lý theo hình thức vòng tròn.

The Structure of an Event

Sự kiện, như được ghi vào một luồng sự kiện, thường được đại diện bằng một khóa, một giá trị và một tiêu đề. Cả ba thành phần này cùng nhau tạo thành bản ghi thể hiện sự kiện.

Cấu trúc chính xác của bản ghi sẽ khác nhau tùy thuộc vào công nghệ bạn chọn. Ví dụ, các hàng đợi và thông điệp tạm thời thường sử dụng các quy tắc và thành phần tương tự nhưng khác nhau, chẳng hạn như khóa tiêu đề, khóa định tuyến và khóa ràng buộc, để kể tên một vài thứ. Nhưng phần lớn, định dạng bản ghi ba phần sau đây thường có thể áp dụng cho tất cả các sự kiện.

- The key

-

Chìa khóa là tùy chọn nhưng cực kỳ hữu ích. Nó thường được đặt thành một ID duy nhất đại diện cho dữ liệu của sự kiện đó, tương tự như khóa chính trong một cơ sở dữ liệu quan hệ. Nó cũng thường được sử dụng để định tuyến sự kiện đến một phân vùng cụ thể của luồng sự kiện. Sẽ có thêm thông tin về điều đó trong chương này.

- The value

-

Chứa phần lớn dữ liệu liên quan đến sự kiện. Nếu bạn coi khóa sự kiện như khóa chính của một dòng trong bảng cơ sở dữ liệu, thì hãy nghĩ giá trị như tất cả các trường khác trong dòng đó. Giá trị mang phần lớn dữ liệu của một sự kiện.

- The header (also known as “record properties”)

-

Chứa siêu dữ liệu về chính sự kiện, và thường là định dạng độc quyền tùy thuộc vào nhà môi giới sự kiện. Bản ghi thường được sử dụng để ghi lại thông tin như ngày giờ, ID theo dõi và các cặp khóa-giá trị do người dùng định nghĩa mà không thích hợp cho giá trị.

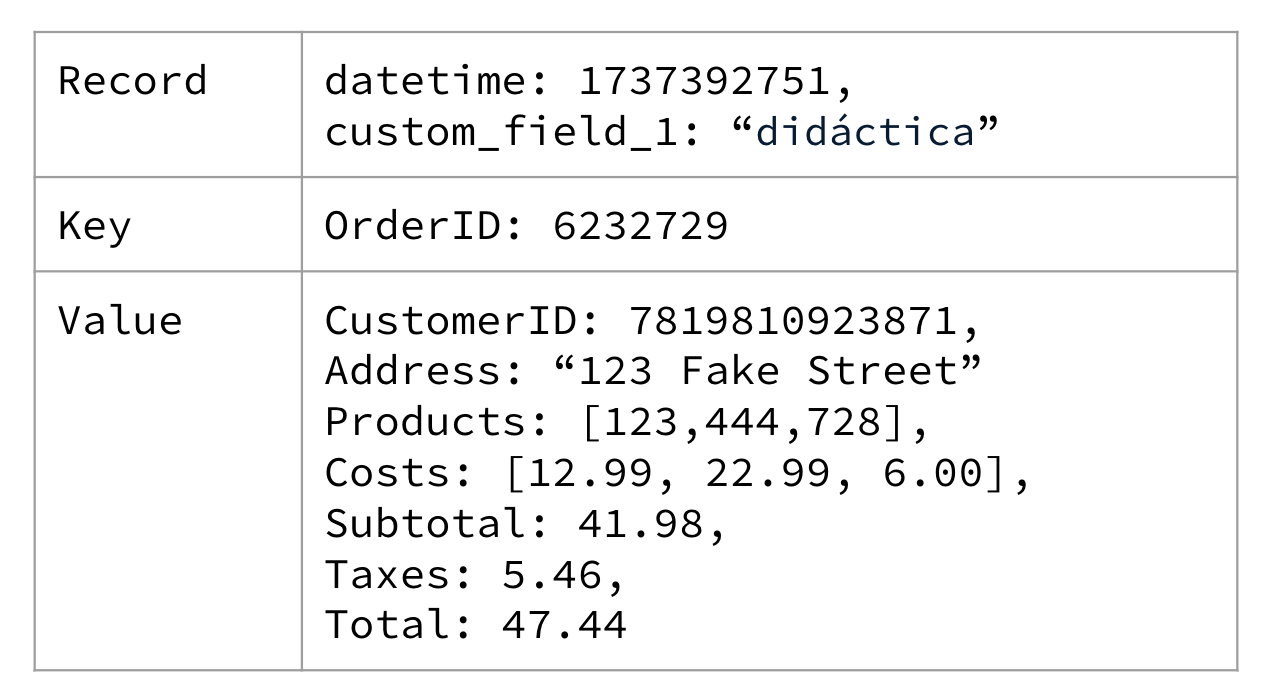

Một ví dụ về cấu trúc bản ghi được hiển thị trong Hình 1-5, chứa một tập hợp thông tin tối thiểu liên quan đến một đơn hàng thương mại điện tử.

Figure 1-5. A simple e-commerce order showing the items purchased by a user, along with the total cost

Các sự kiện là bất biến. Bạn không thể sửa đổi một sự kiện sau khi nó được phát hành vào dòng sự kiện. Tính bất biến là một thuộc tính thiết yếu để đảm bảo rằng các người tiêu dùng đều có quyền truy cập vào cùng một dữ liệu. Việc thay đổi dữ liệu đã được đọc bởi nhiều người tiêu dùng thì không có lợi, vì không có cách nào dễ dàng để thông báo cho họ rằng họ phải thực hiện thay đổi đối với dữ liệu mà họ đã đọc. Tuy nhiên, bạn có thể tạo và phát hành các sự kiện mới chứa các sửa đổi hoặc cập nhật cần thiết, được trình bày rõ hơn trong chương [Liên kết sẽ đến].

Các sự kiện thường được phân loại thành ba loại chính: sự kiện không khóa, sự kiện có khóa và sự kiện thực thể. Hãy cùng xem xét kỹ lưỡng từng loại.

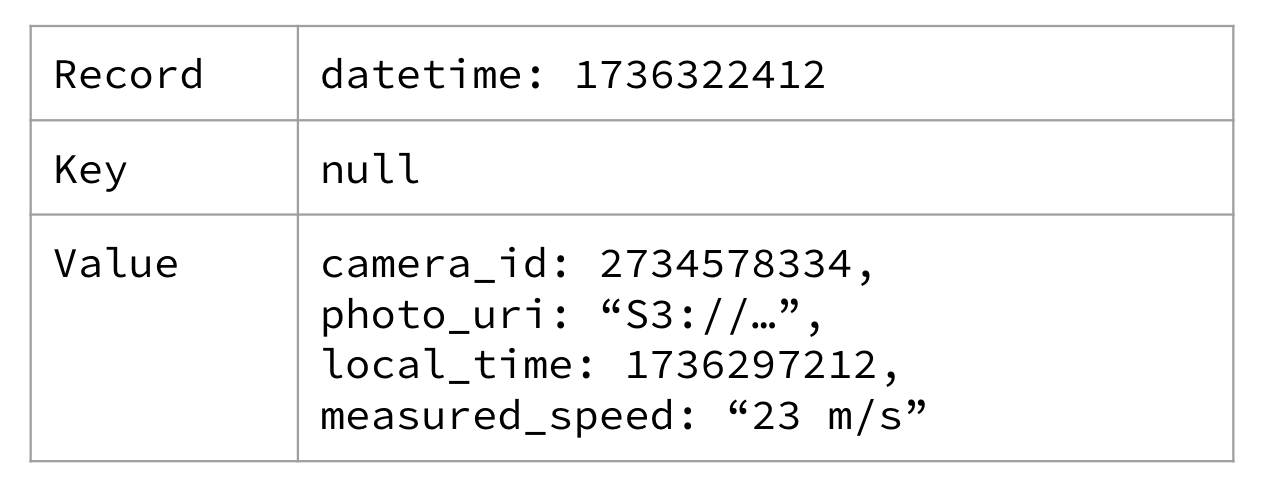

Unkeyed Event

Các sự kiện không có khóa không chứa khóa. Chúng thường được coi là hoàn toàn độc lập với nhau. Không có sự xử lý đặc biệt nào cho việc định tuyến tới một phân vùng cụ thể.

Các sự kiện không khóa thường là một dạng đo lường thô. Ví dụ, một chiếc máy ảnh chụp lại hình ảnh một chiếc ô tô chạy qua đèn đỏ có thể tạo ra một sự kiện không khóa, như được thể hiện trong Hình 1-6.

Figure 1-6. An unkeyed red light traffic camera event

Có thể camera tín hiệu đỏ đã tạo ra sự kiện với camera_id làm khóa không? Chắc chắn rồi! Nhưng nó đã không làm vậy, vì nó chỉ ghi lại dữ liệu theo định dạng cụ thể đó, và camera cụ thể này không hỗ trợ xử lý hậu kỳ tùy chỉnh. Bạn nhận được sự kiện theo định dạng mà nó chỉ định trong hướng dẫn sử dụng.

Nếu chúng ta muốn thêm một khóa, chúng ta sẽ phải thực hiện một số xử lý bổ sung và phát ra một luồng sự kiện mới, như bạn sẽ thấy trong phần tiếp theo.

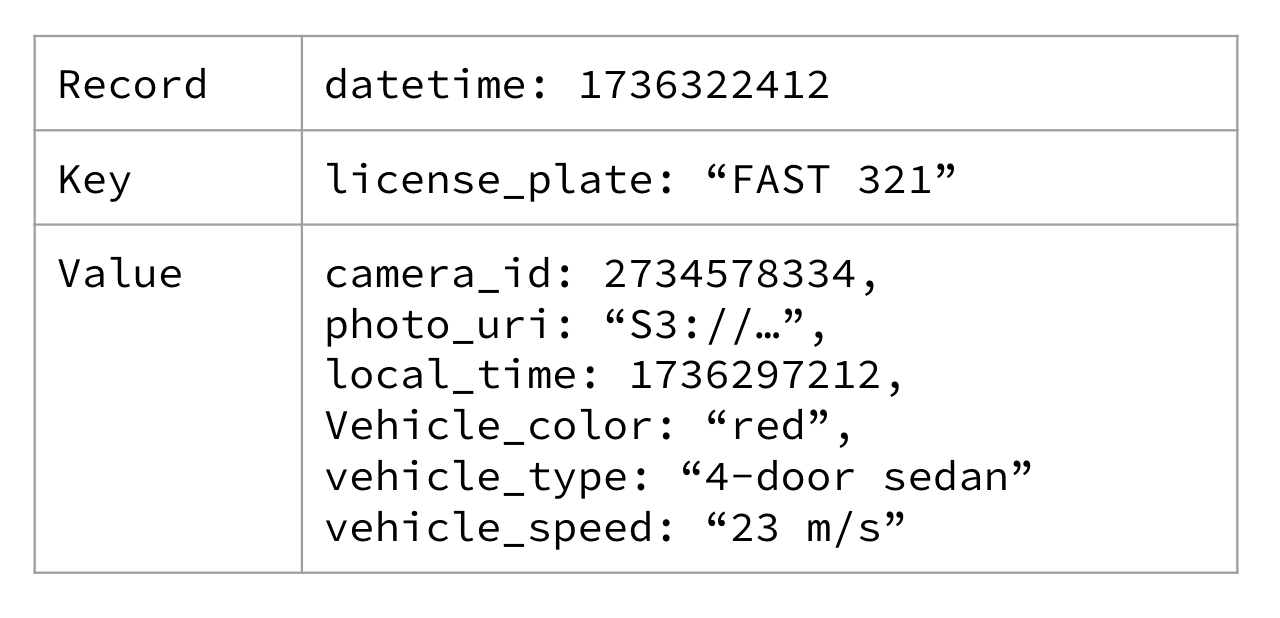

Keyed Events

Các sự kiện có khóa chứa một khóa không null liên quan đến điều gì đó quan trọng về sự kiện. Khóa sự kiện được xác định bởi dịch vụ sản xuất khi nó tạo ra bản ghi và giữ nguyên không thay đổi sau khi được ghi vào luồng sự kiện.

Nếu chúng ta áp dụng một khóa cho dữ liệu camera giao thông tín hiệu đỏ, chúng ta có thể chọn sử dụng biển số xe của người lái. Bạn có thể xem một ví dụ về điều đó trong Hình 1-7.

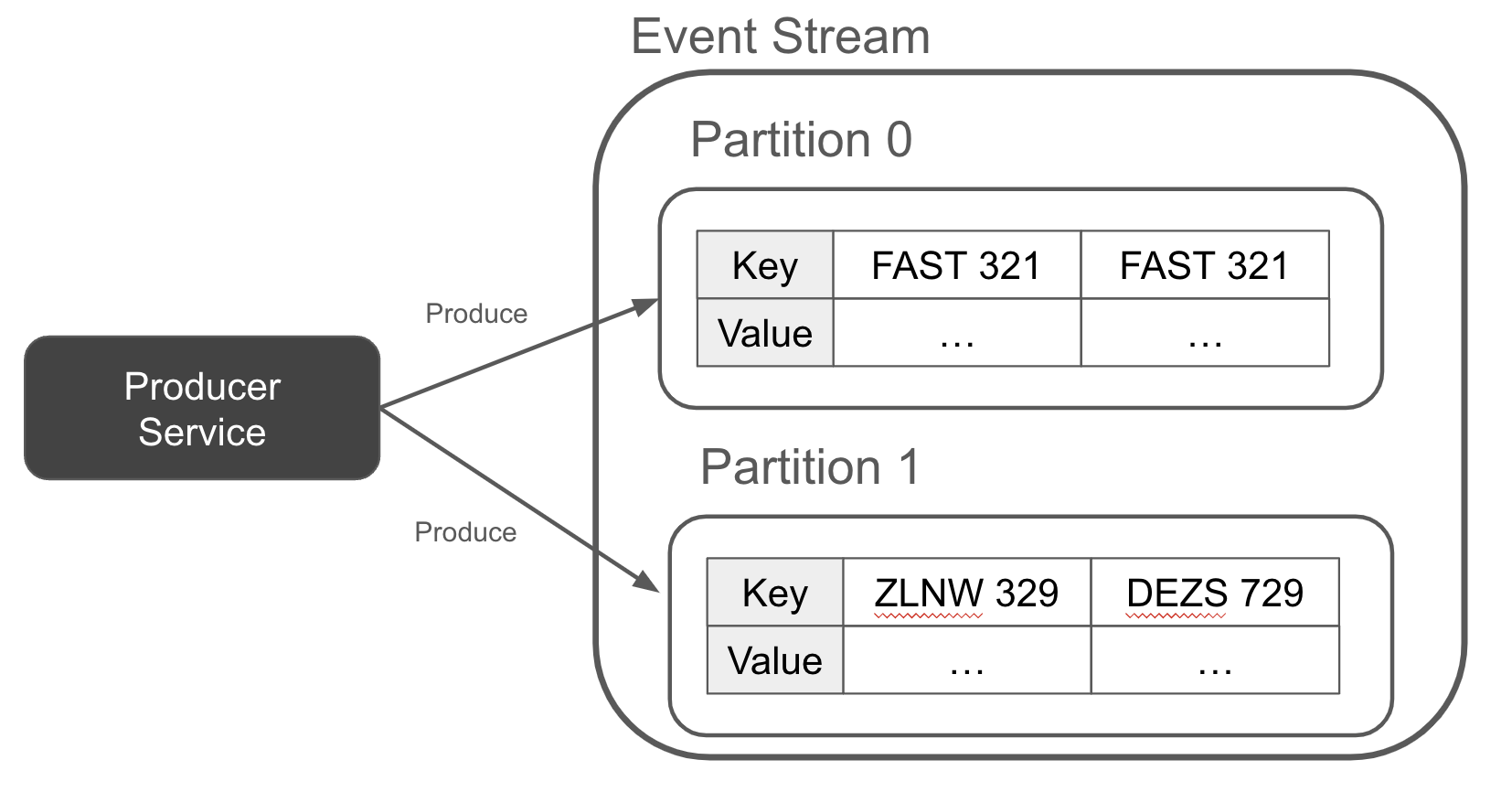

Figure 1-7. A red light traffic camera event keyed on the driver’s license plate

Một khóa cho phép nhà sản xuất phân vùng các bản ghi một cách xác định, với tất cả các bản ghi của cùng một khóa được đưa vào cùng một phân vùng sự kiện, như được mô tả trong Hình 1-8. Điều này cung cấp cho người tiêu dùng sự kiện của bạn một đảm bảo rằng tất cả dữ liệu của một khóa nhất định sẽ chỉ nằm trong một phân vùng duy nhất. Ngược lại, người tiêu dùng của bạn có thể dễ dàng phân chia công việc dựa trên từng phân vùng, biết rằng bất kỳ công việc nào dựa trên khóa mà họ thực hiện sẽ chỉ phụ thuộc vào việc đọc một phân vùng duy nhất, chứ không phải tất cả các sự kiện từ tất cả các phân vùng.

Figure 1-8. A red light traffic camera event keyed on the driver’s license plate

Như đã được minh họa trong chủ đề phân tách, bạn có thể thấy rằng có ít nhất hai sự kiện cho FAST 321. Mỗi sự kiện trong số này đại diện cho một lần xe chạy qua đèn đỏ. Hãy ghi nhớ điều này khi chúng ta đến với phân loại sự kiện cuối cùng, sự kiện thực thể.

Entity Event

Một sự kiện thực thể đại diện cho một thứ duy nhất và được xác định bằng ID duy nhất của thứ đó. Nó mô tả các thuộc tính và trạng thái của thực thể tại một thời điểm cụ thể. Các sự kiện thực thể cũng thỉnh thoảng được gọi là sự kiện trạng thái, vì chúng đại diện cho trạng thái của một thứ cụ thể tại một thời điểm nhất định.

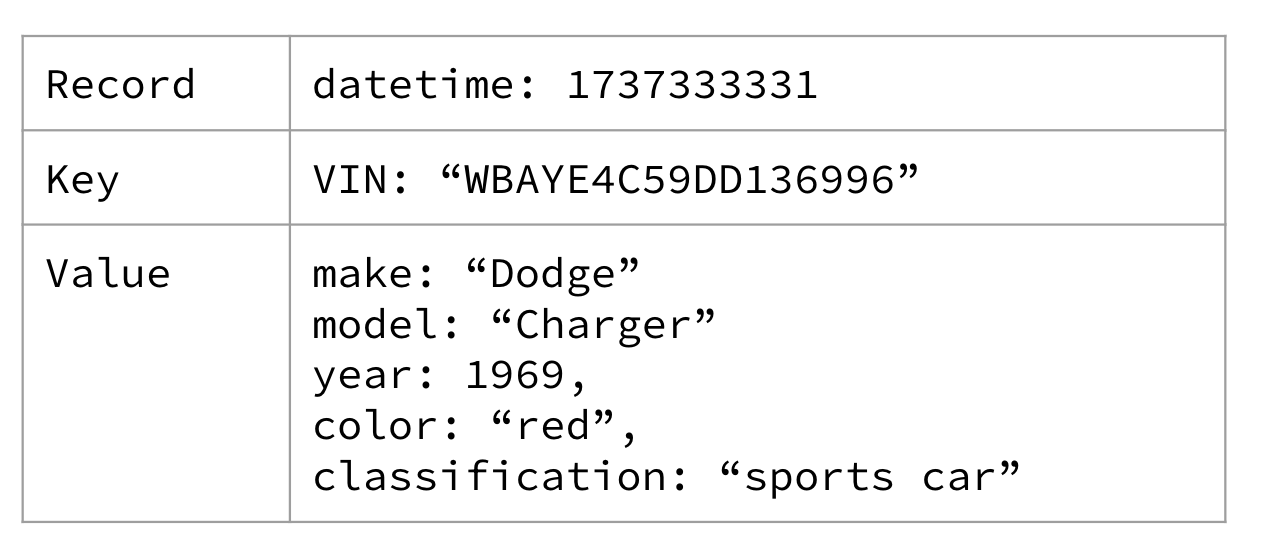

Để có điều gì đó cụ thể hơn, và tiếp tục với phép loại suy về camera giao thông, bạn có thể mong đợi thấy một chiếc xe như một sự kiện thực thể. Bạn cũng có thể thấy các sự kiện thực thể cho Người lái xe, Lốp xe, Ngã tư, hoặc bất kỳ “thứ” nào khác liên quan đến tình huống. Một thực thể xe được trình bày trong Hình 1-9.

Figure 1-9. A Car entity describing the sports car that keeps running the red lights

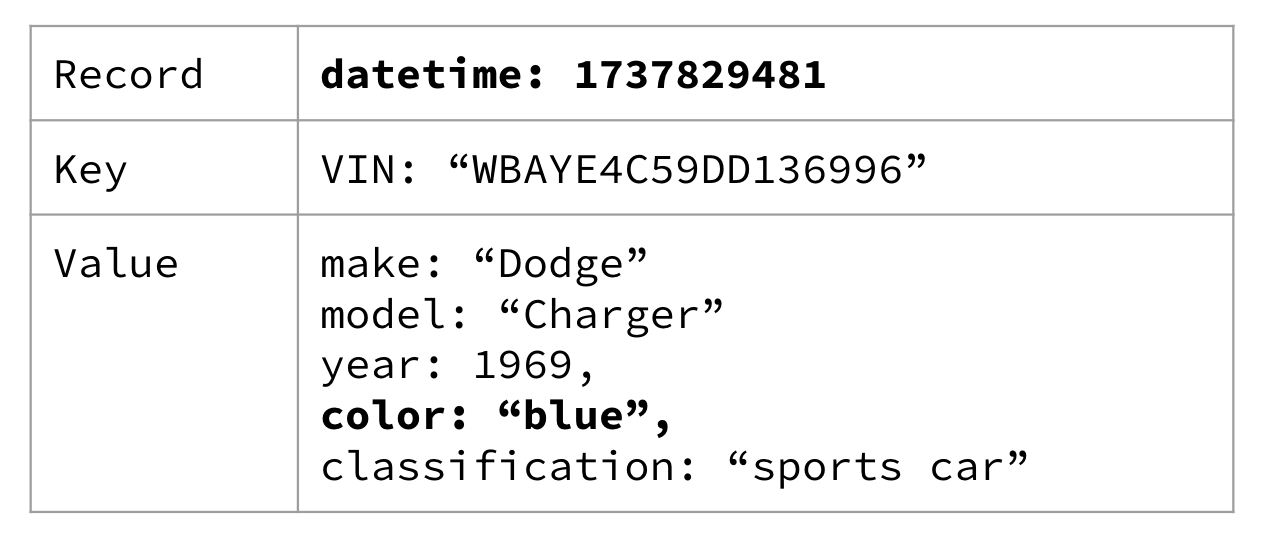

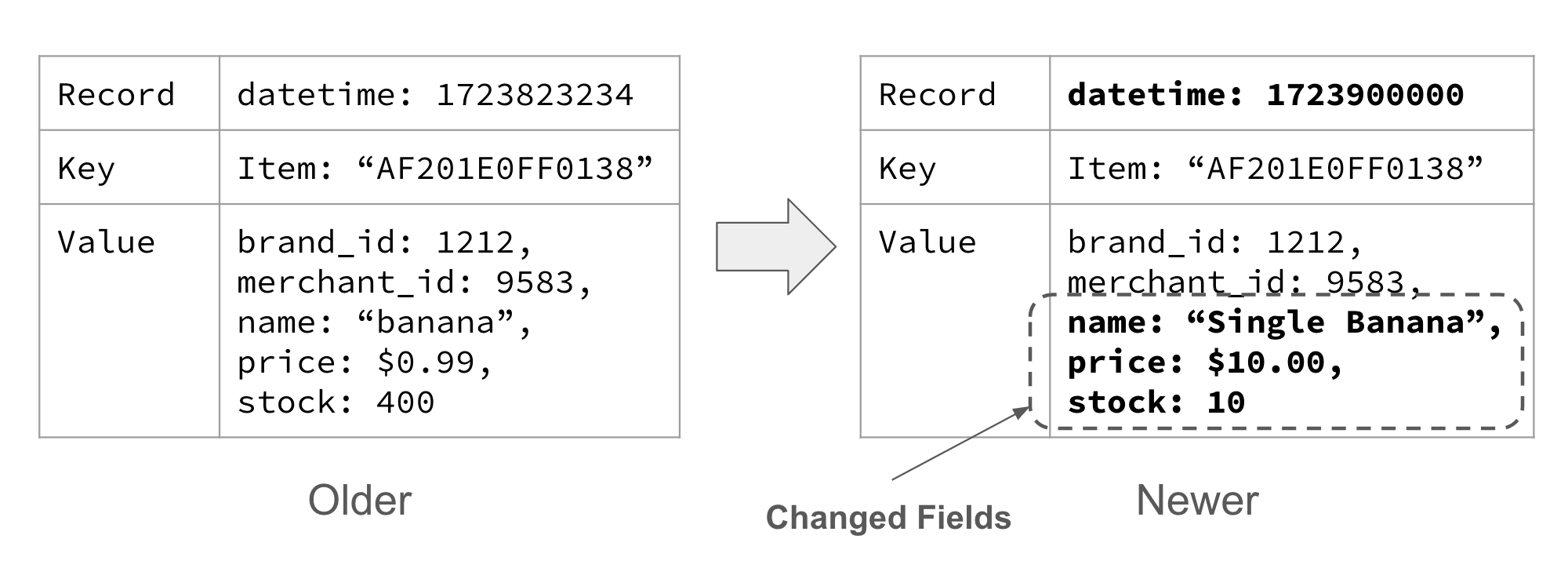

Bạn có thể thấy hữu ích khi nghĩ về một sự kiện của thực thể giống như bạn nghĩ về một hàng trong bảng cơ sở dữ liệu. Cả hai đều có một khóa chính, và cả hai đại diện cho dữ liệu của khóa chính đó như nó đang ở thời điểm hiện tại. Và giống như một hàng trong cơ sở dữ liệu, dữ liệu chỉ hợp lệ trong khoảng thời gian dữ liệu đó vẫn không thay đổi. Do đó, nếu bạn sơn lại chiếc xe thành màu xanh, bạn có thể mong đợi thấy một sự kiện mới với màu sắc được cập nhật, như trong Hình 1-10.

Figure 1-10. The car has been repainted blue

Bạn cũng có thể nhận thấy rằng trường datetime đã được cập nhật để thể hiện khi chiếc xe được sơn màu xanh (hoặc ít nhất là khi nó được báo cáo). Bạn cũng sẽ nhận thấy rằng sự kiện thực thể cũng chứa tất cả dữ liệu không thay đổi. Điều này là có ý định, và thực sự cho phép chúng ta thực hiện một số điều khá mạnh mẽ với các sự kiện thực thể - nhưng chúng ta sẽ đề cập đến điều đó một cách chi tiết hơn trong Chương 3.

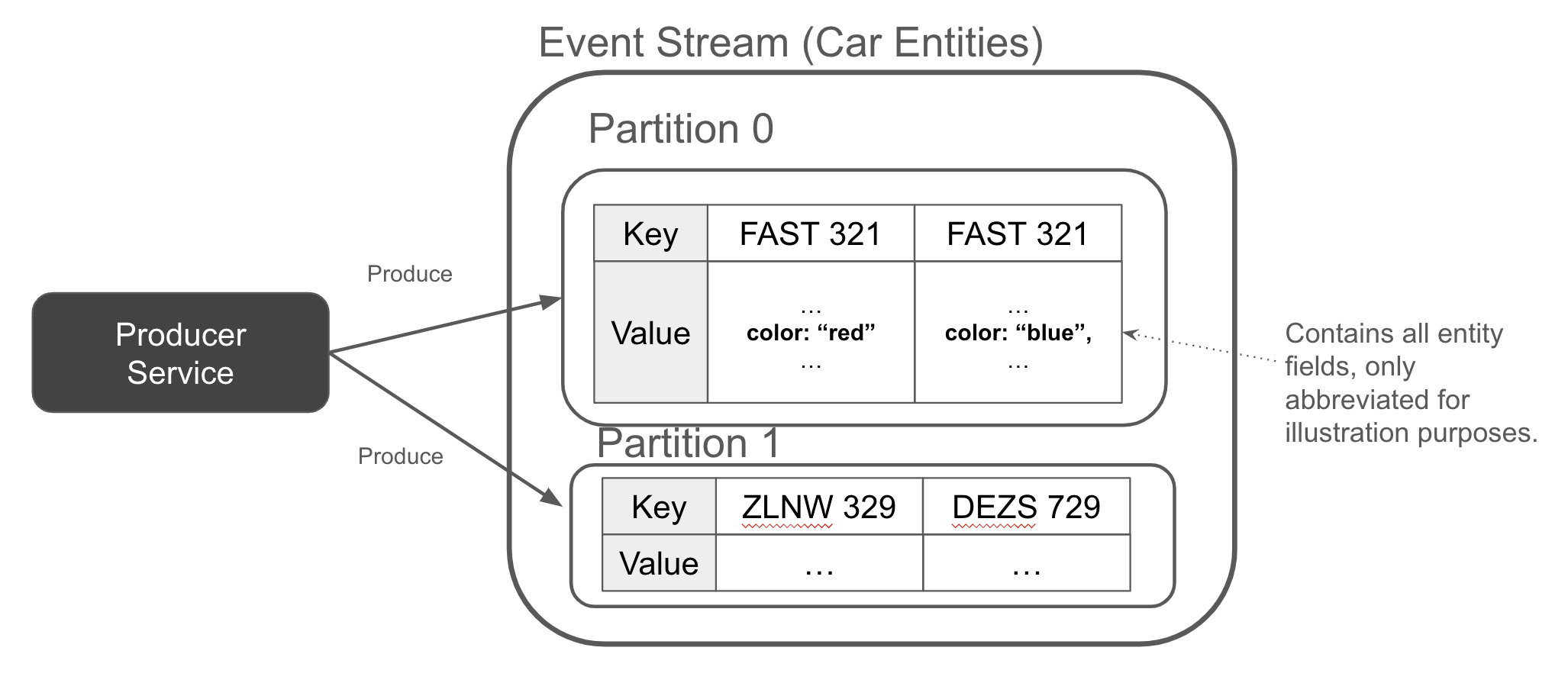

Tương tự như cách các sự kiện có khóa đều được gửi đến cùng một phân vùng, điều này cũng đúng với các sự kiện thực thể. Hình 1-11 cho thấy một luồng sự kiện với hai sự kiện cho FAST 321 - một khi nó màu đỏ (sự kiện cũ nhất), và một khi nó màu xanh (sự kiện mới nhất, được thêm vào cuối luồng).

Figure 1-11. The producer appends a full entity event whenever an entity is created, updated, or deleted

Các sự kiện thực thể đặc biệt quan trọng trong các kiến trúc hướng sự kiện. Chúng cung cấp một lịch sử liên tục về trạng thái của một thực thể và có thể được sử dụng để hiện thực hóa trạng thái (được đề cập trong phần tiếp theo).

Có nhiều điều hơn nữa về thiết kế sự kiện so với những gì chúng ta đã đề cập trong chương này, nhưng chúng ta sẽ tạm hoãn việc đi sâu vào điều đó cho đến chương [Liên kết sẽ có]. Thay vào đó, hãy cùng xem cách chúng ta có thể sử dụng những sự kiện mà chúng ta vừa giới thiệu để xây dựng các dịch vụ vi mô dựa trên sự kiện trong thế giới thực.

Aggregating State from Keyed Events

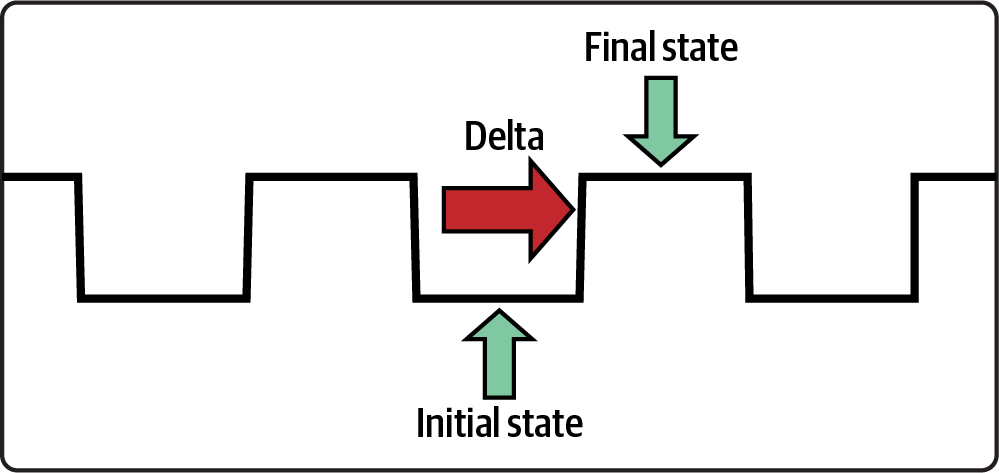

Một phép tổng hợp là quá trình tiêu thụ hai hoặc nhiều sự kiện và kết hợp chúng thành một kết quả duy nhất. Các phép tổng hợp là một nguyên lý xử lý dữ liệu phổ biến cho các kiến trúc dựa trên sự kiện, và là một trong những cách chính để tạo ra trạng thái từ một loạt các sự kiện. Việc xây dựng một phép tổng hợp yêu cầu lưu trữ và duy trì trạng thái bền vững, sao cho tiến trình tổng hợp được bảo tồn nếu dịch vụ gặp sự cố. Trạng thái và phục hồi sẽ được đề cập trong chương [Link to Come].

Sự kiện được khóa đóng vai trò quan trọng trong việc tổng hợp, vì tất cả dữ liệu cùng một khóa nằm trong cùng một phân vùng. Do đó, bạn có thể đơn giản tổng hợp một khóa duy nhất bằng cách đọc một phân vùng duy nhất. Nếu bạn đang đọc nhiều chủ đề, thì bạn cần đảm bảo rằng chúng được phân vùng giống nhau - nếu không, bạn sẽ phải phân vùng lại dữ liệu để các luồng khớp với nhau. Việc phân vùng lại và đồng phân vùng sẽ được đề cập chi tiết hơn trong chương [Liên kết sẽ đến].

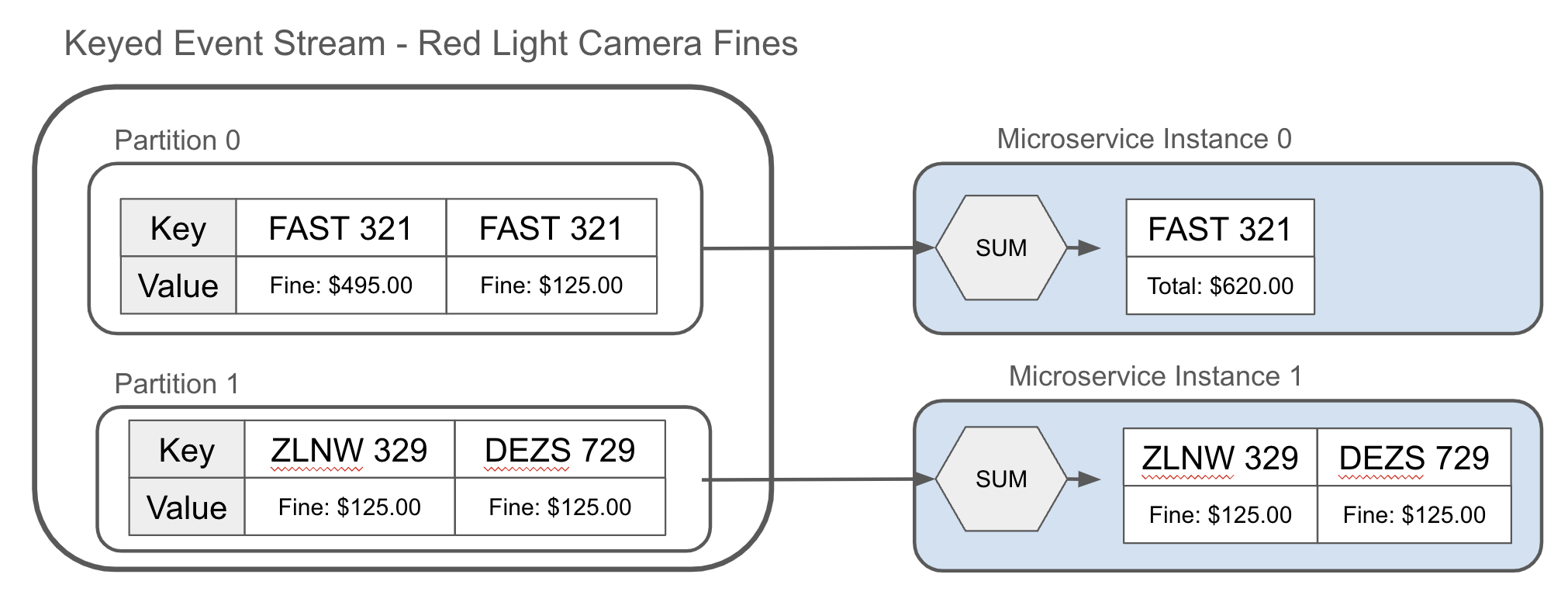

Một phép tổng hợp có thể đơn giản như một tổng, như được thể hiện trong Hình 1-12. Ví dụ, tổng hợp số vé phạt giao thông đã được cấp cho chủ sở hữu của một chiếc xe thể thao có tốc độ cao và tính tổng số tiền phải trả.

Figure 1-12. Aggregating the keyed events of the red light camera fines

Các phép tổng hợp cũng có thể phức tạp hơn, bao gồm nhiều luồng đầu vào, nhiều loại sự kiện và các máy trạng thái nội bộ để thu được kết quả phức tạp hơn. Chúng ta sẽ xem lại các phép tổng hợp trong suốt cuốn sách, nhưng bây giờ, hãy cùng xem xét việc vật chất hóa.

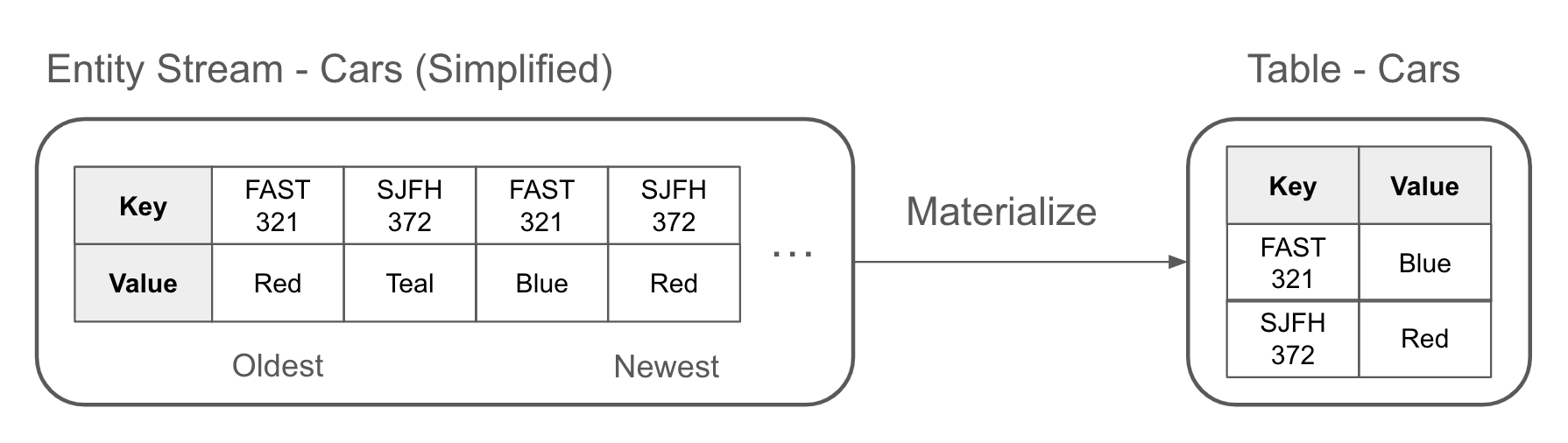

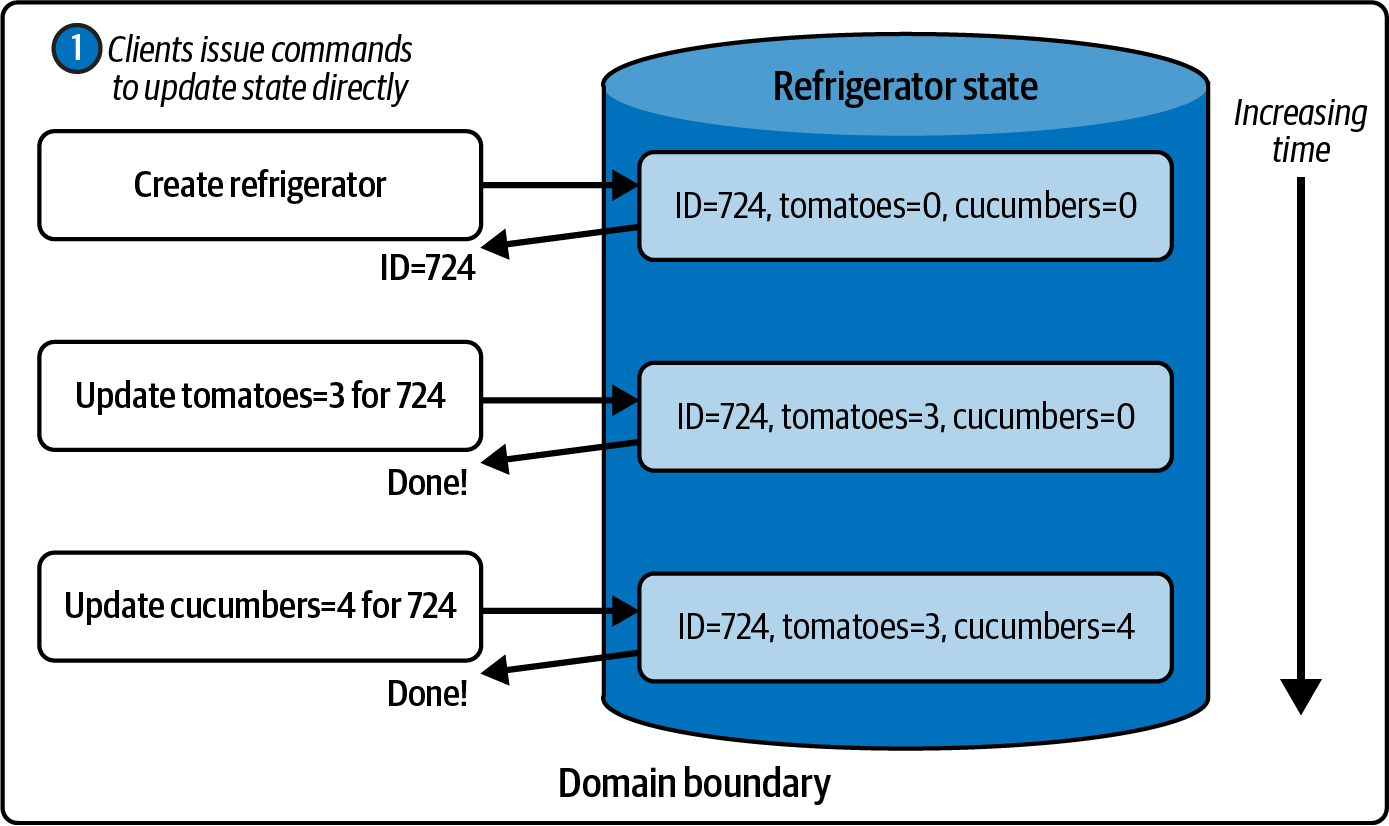

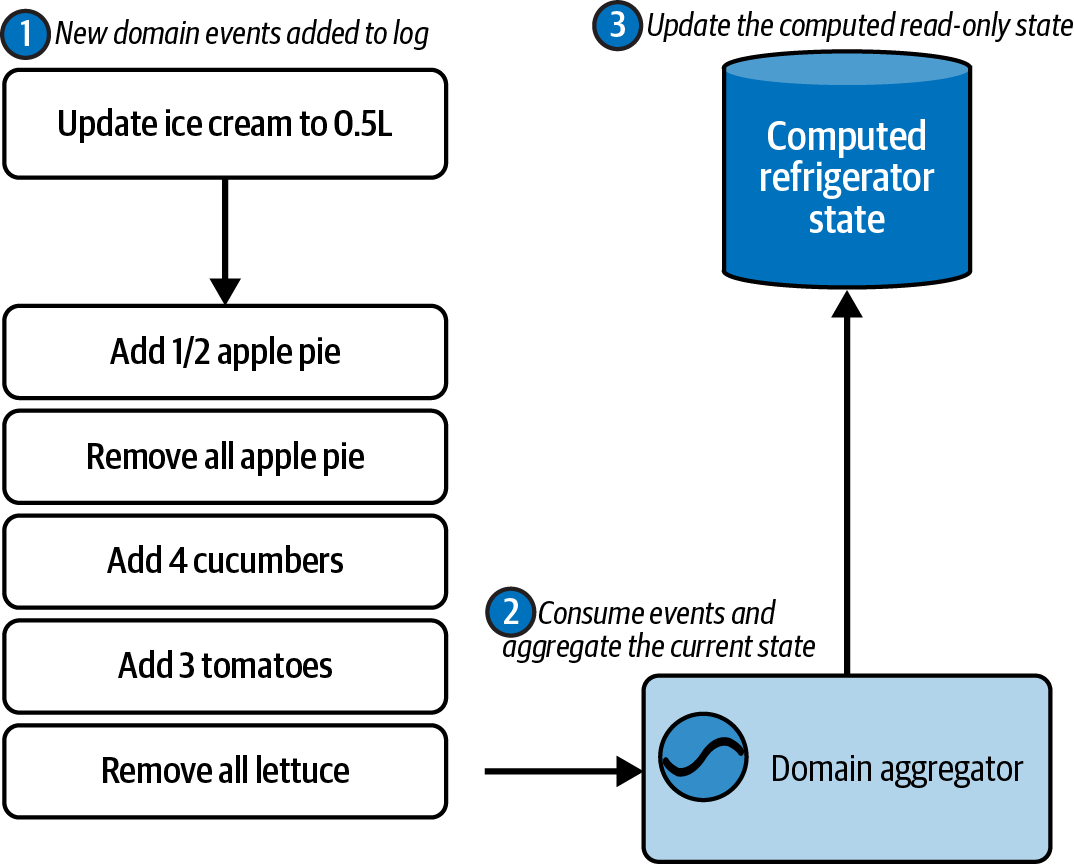

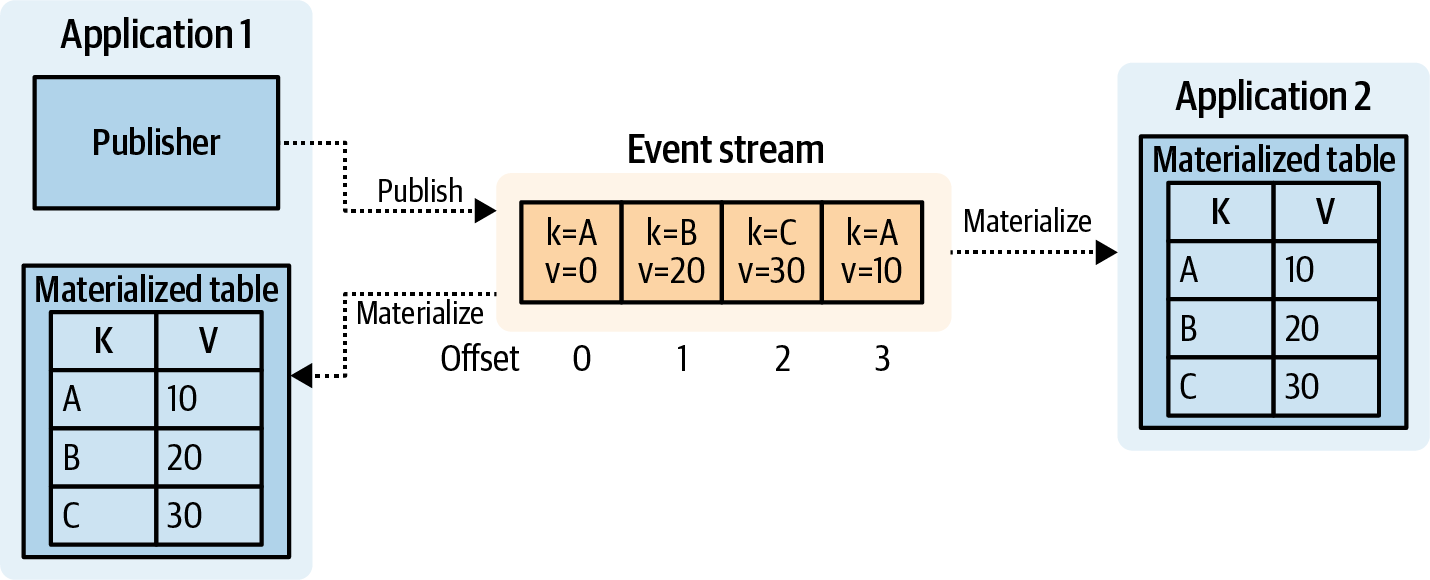

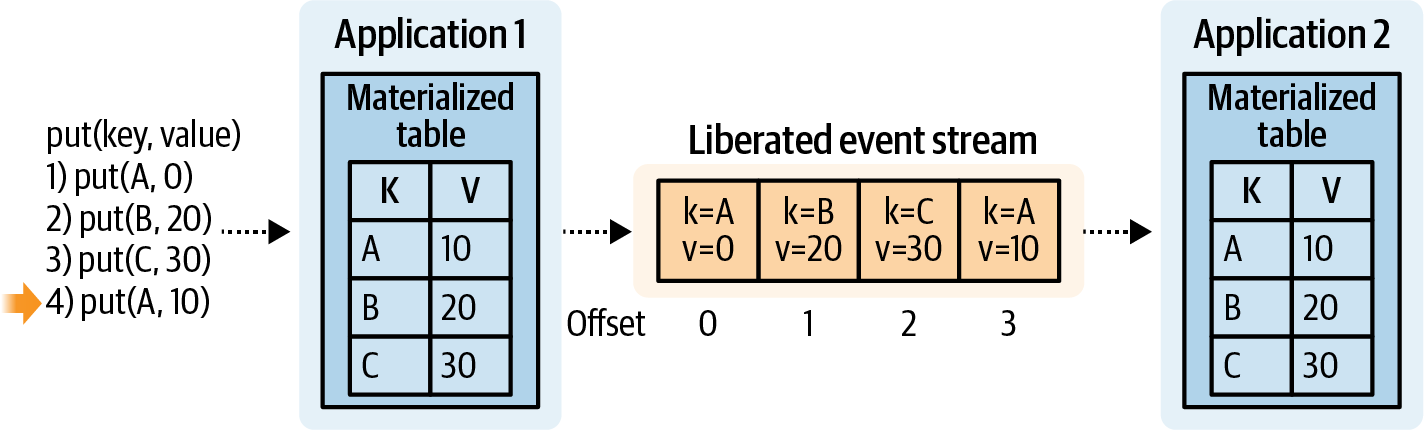

Materializing State from Entity Events

Một sự vật hóa là một dự báo của một luồng vào một bảng. Bạn vật hóa một bảng bằng cách áp dụng các sự kiện thực thể, theo thứ tự, từ một luồng sự kiện thực thể. Mỗi sự kiện thực thể được chèn hoặc cập nhật vào bảng, sao cho sự kiện được đọc gần đây nhất cho một khóa nhất định được đại diện. Điều này được minh họa trong Hình 1-13, nơi FAST 321 và SJFH 372 đều có giá trị mới nhất trong bảng đã được vật hóa của chúng.

Figure 1-13. Materializing an event stream into a table

Bạn cũng có thể chuyển đổi một bảng thành một luồng sự kiện thực thể bằng cách công bố mỗi bản cập nhật vào luồng sự kiện.

Tip

Định lý đối xứng luồng-bảng là nguyên tắc rằng một luồng có thể được biểu diễn bằng một bảng, và một bảng có thể được biểu diễn dưới dạng luồng. Điều này rất cơ bản trong việc chia sẻ trạng thái giữa các dịch vụ vi mô theo sự kiện, mà không có bất kỳ sự ràng buộc trực tiếp nào giữa các dịch vụ sản xuất và tiêu thụ.

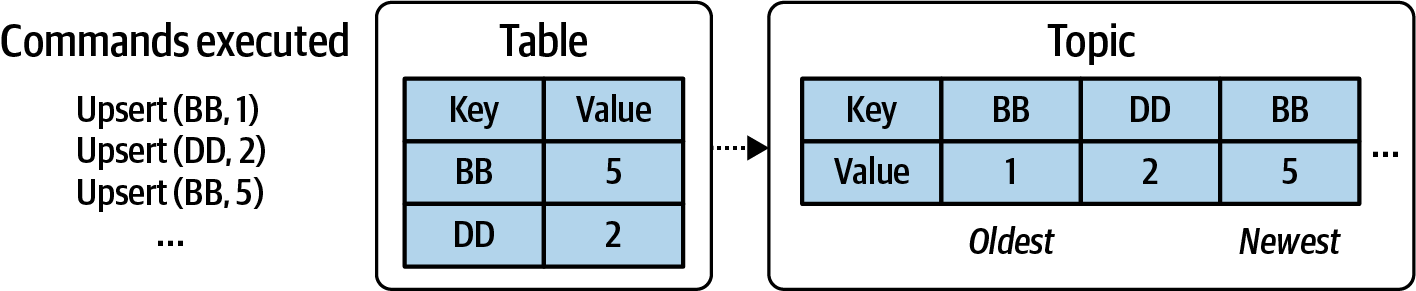

Theo cách tương tự, bạn có thể có một bảng ghi lại tất cả các cập nhật và qua đó tạo ra một luồng dữ liệu đại diện cho trạng thái của bảng theo thời gian. Trong ví dụ sau, BB được upsert hai lần, trong khi DD chỉ được upsert một lần. Luồng đầu ra trong Hình 1-14 cho thấy ba sự kiện upsert đại diện cho những thao tác này.

Figure 1-14. Generating an event stream from the changes applied to a table

Một bảng cơ sở dữ liệu quan hệ, chẳng hạn, được tạo ra và điền dữ liệu thông qua một loạt các lệnh chèn, cập nhật và xóa dữ liệu. Những lệnh này có thể được sản xuất dưới dạng sự kiện vào một nhật ký không thay đổi, chẳng hạn như một tệp chỉ thêm tại chỗ (như nhật ký nhị phân trong MySQL) hoặc một luồng sự kiện bên ngoài. Bằng cách phát lại toàn bộ nội dung của nhật ký, bạn có thể tái tạo chính xác bảng và tất cả dữ liệu của nó.

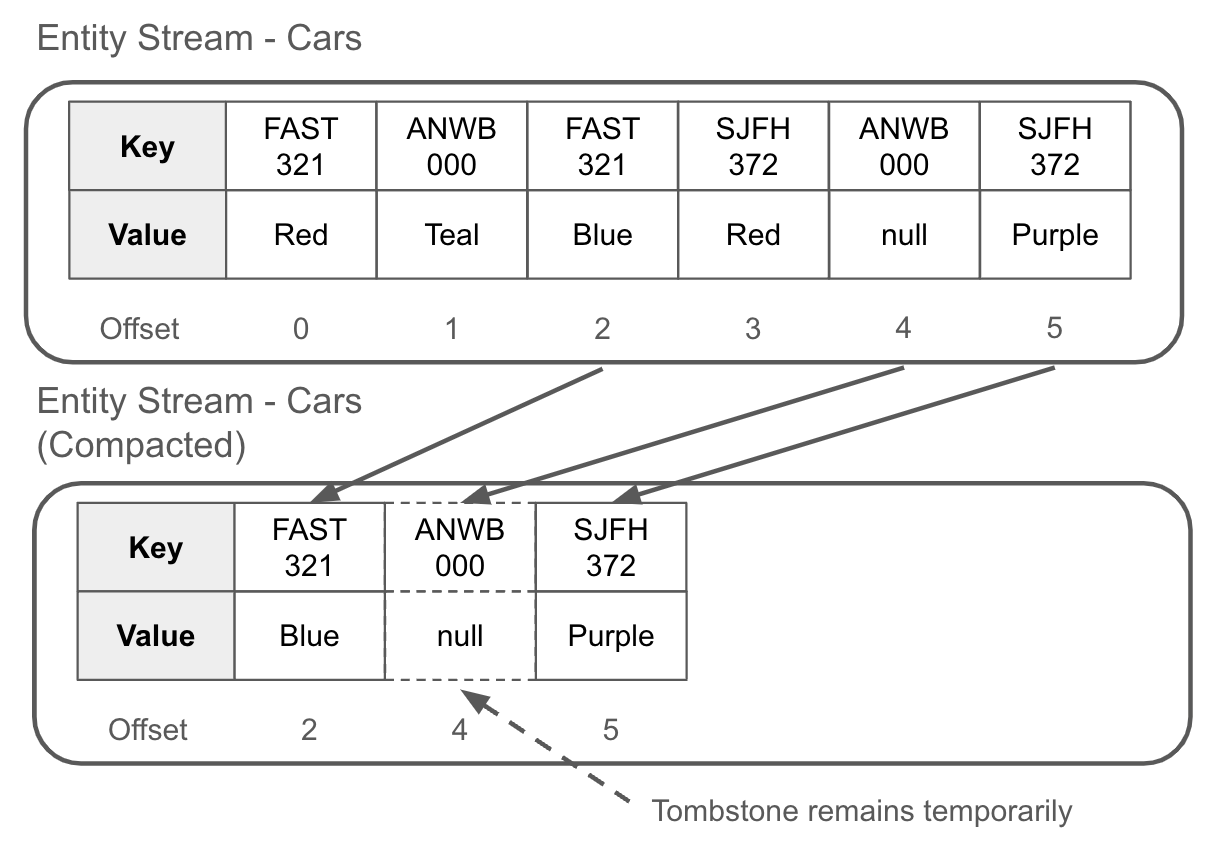

Deleting Events and Event Stream Compaction

Đầu tiên, tin xấu. Bạn không thể xóa một bản ghi khỏi luồng sự kiện như cách bạn xóa một hàng trong bảng cơ sở dữ liệu. Một phần lớn giá trị của luồng sự kiện là tính bất biến của nó. Nhưng bạn có thể phát hành một sự kiện mới, được gọi là tombstone, cho phép bạn xóa các bản ghi có cùng khóa. Tombstone thường được sử dụng nhiều nhất với các luồng sự kiện của thực thể.

Một bia mộ (tombstone) là một sự kiện có khóa với giá trị được đặt là null, đây là một quy ước được thiết lập bởi dự án Apache Kafka. Bia mộ phục vụ hai mục đích. Đầu tiên, chúng báo hiệu cho người tiêu dùng rằng dữ liệu liên quan đến khóa sự kiện đó bây giờ nên được xem là đã bị xóa. Để sử dụng phép so sánh với cơ sở dữ liệu, việc xóa một hàng từ bảng sẽ tương đương với việc phát hành một bia mộ vào một luồng sự kiện dành cho cùng một khóa chính.

Thứ hai, bia mộ cho phép việc nén. Nén là một quá trình của trình môi giới sự kiện nhằm giảm kích thước của các luồng sự kiện bằng cách chỉ giữ lại các sự kiện gần đây nhất cho một khóa nhất định. Các sự kiện cũ hơn bia mộ sẽ bị xóa, và các sự kiện còn lại được nén lại thành một tập hợp nhỏ hơn các tệp dễ đọc và nhanh chóng hơn. Các offset của luồng sự kiện được duy trì để không cần thay đổi từ phía người tiêu dùng. Hình 1-15 minh họa sự nén logic của một luồng sự kiện trong trình môi giới sự kiện.

Figure 1-15. After a compaction, only the most recent record is kept for a given key — all predecessors records of the same key are deleted

Bản ghi tombstone thường chỉ tồn tại trong luồng sự kiện trong một khoảng thời gian ngắn. Trong trường hợp của Apache Kafka, giá trị mặc định là 24 giờ cho phép người tiêu dùng có cơ hội đọc tombstone trước khi nó cũng bị (asynchronously) dọn dẹp.

Quá trình nén là một quá trình không đồng bộ chỉ được thực hiện khi đáp ứng một tập hợp tiêu chí nhất định, bao gồm tỷ lệ bẩn hoặc số lượng bản ghi trong các phân đoạn không hoạt động. Bạn cũng có thể kích hoạt nén thủ công. Cách thức cụ thể của quá trình nén thay đổi tùy theo lựa chọn trình xử lý sự kiện, vì vậy bạn sẽ phải tham khảo tài liệu của mình cho phù hợp.

Nén giảm cả việc sử dụng đĩa và số lượng sự kiện cần được xử lý để đạt được trạng thái hiện tại, với cái giá là loại bỏ một phần lịch sử luồng sự kiện. Nén thường cung cấp một số cấu hình và đảm bảo hữu ích, bao gồm:

- Minimum Compaction Lag

-

Bạn có thể chỉ định khoảng thời gian tối thiểu mà một bản ghi phải tồn tại trong luồng sự kiện trước khi nó đủ điều kiện để được nén. Ví dụ, Apache Kafka cung cấp thuộc tính min.compaction.lag.ms cho các chủ đề của nó. Bạn có thể đặt giá trị này thành một giá trị hợp lý, chẳng hạn như 24 giờ hoặc 7 ngày, để đảm bảo rằng các người tiêu dùng của bạn có thể đọc dữ liệu trước khi nó bị nén đi.

- Offset Guarantees

-

Các offset không thay đổi trước, trong và sau khi nén. Nén sẽ tạo ra khoảng trống giữa các offset liên tiếp, nhưng sẽ không có hậu quả nào cho người tiêu dùng tiêu thụ tuần tự luồng sự kiện. Cố gắng đọc một offset cụ thể không còn tồn tại sẽ dẫn đến một lỗi.

- Consistency Guarantees

-

Một người tiêu dùng đọc từ đầu một chủ đề đã nén có thể tạo ra một bảng chính xác giống hệt như một người tiêu dùng đã chạy từ đầu.

Caution

Mặc dù bạn có thể tìm thấy các công cụ cho phép bạn xóa thủ công các bản ghi từ một luồng sự kiện, nhưng hãy rất cẩn thận. Việc xóa thủ công các bản ghi có thể dẫn đến những kết quả không mong muốn, đặc biệt nếu bạn có các kẻ tiêu thụ đã đọc dữ liệu. Chỉ xóa các bản ghi sẽ không sửa chữa được trạng thái do các kẻ tiêu thụ tạo ra. Việc ngăn chặn dữ liệu xấu là rất quan trọng, và chúng tôi sẽ đề cập đến điều đó nhiều hơn trong chương [Liên kết sẽ đến].

Sự đối xứng giữa stream và bảng cùng với việc vật chất hóa cho phép các dịch vụ của chúng tôi giao tiếp trạng thái với nhau. Việc nén cho phép chúng tôi giữ các luồng sự kiện của mình ở kích thước hợp lý, phù hợp với miền dữ liệu.

The Kappa Architecture

Kiến trúc Kappa lần đầu tiên được trình bày vào năm 2014 bởi Jay Kreps, người đồng sáng lập Apache Kafka và đồng sáng lập Confluent. Kiến trúc Kappa dựa vào các luồng sự kiện như là bản ghi duy nhất cho cả dữ liệu hiện tại và dữ liệu lịch sử. Người tiêu dùng chỉ cần bắt đầu tiêu thụ từ đầu luồng để có cái nhìn tổng quát về mọi thứ đã xảy ra kể từ khi bắt đầu, cuối cùng đến đầu luồng và các sự kiện mới nhất như trong Hình 1-16.

Figure 1-16. Kappa Architecture, with each service building its state from just an event stream

Kiến trúc Kappa không sử dụng kho lưu trữ thứ cấp cho dữ liệu lịch sử, như trong kiến trúc Lambda (sẽ bàn thêm về điều đó trong phần tiếp theo). Kappa hoàn toàn dựa vào luồng sự kiện để lưu trữ và phục vụ.

Các kiến trúc Kappa chỉ được hiện thực hóa với các trình môi giới sự kiện hiện đại, kết hợp với lưu trữ giá rẻ được đưa vào bởi cuộc cách mạng điện toán đám mây. Việc lưu trữ bao nhiêu dữ liệu tùy thích trong luồng trở nên dễ dàng và tiết kiệm chi phí, và bạn không còn bị giới hạn bởi các công nghệ môi giới áp dụng TTL bắt buộc, xóa các bản ghi của bạn sau vài giờ hoặc vài ngày.

Microservices theo hướng sự kiện chỉ cần tạo ra trạng thái của riêng chúng từ các luồng khi cần. Không cần truy cập dữ liệu từ một kho lưu trữ thứ cấp ở đâu đó, cũng như không có bất kỳ độ phức tạp nào trong việc quản lý quyền truy cập bổ sung. Nó sạch sẽ, đơn giản và dễ dàng lập trình.

Có một số đánh đổi với Kappa. Mỗi dịch vụ phải xây dựng trạng thái riêng của nó, và đối với các tập dữ liệu cực lớn, việc hiện thực hóa từ luồng sự kiện có thể mất một khoảng thời gian. Số lượng phân vùng thấp và sự song song không đủ có thể khiến dịch vụ của bạn mất nhiều giờ hoặc vài ngày để hiện thực hóa. Điều này thường được gọi là “thời gian hydrat hóa”, và bạn sẽ cần lên kế hoạch cho nó trong vòng đời dịch vụ của mình.

Bạn có thể giảm thiểu vấn đề thời gian hydrate bằng cách duy trì các bản chụp nhanh hoặc sao lưu trạng thái đã được tính toán và hóa thành. Khi tải ứng dụng của bạn, dịch vụ của bạn chỉ cần tải từ dữ liệu đã sao lưu và khôi phục quá trình từ nơi nó đã dừng lại. Mặc dù đây là trách nhiệm của chính ứng dụng, nhưng các bản chụp nhanh và sao lưu đi kèm với các công nghệ xử lý luồng hàng đầu như Apache Kafka Streams, Apache Flink và Apache Spark Streaming, chỉ là một vài trong số các công ty hàng đầu mã nguồn mở trong ngành.

Kiến trúc Kappa là chìa khóa để xây dựng các microservices phi tập trung dựa trên sự kiện, vì nó cung cấp cho các dịch vụ của bạn một đảm bảo mạnh mẽ duy nhất - rằng luồng sự kiện của bạn có thể đóng vai trò là nguồn thông tin duy nhất cho một tập hợp dữ liệu nhất định. Không cần phải tìm đến nơi khác để lấy dữ liệu từ kho thứ hai hoặc thứ ba. Tất cả dữ liệu bạn cần đều nằm trong luồng sự kiện đó, sẵn sàng cho các dịch vụ của bạn.

Kiến trúc Kappa trông như thế nào trong mã?

Ví dụ 1-1 cho thấy một ứng dụng Kafka Streams với hai KTables, mà chỉ là một stream được hiện thực hóa thành một bảng bằng cách sử dụng ECST. Tiếp theo, KTable tồn kho và KTable bán hàng được kết hợp bằng cách sử dụng INNER join không có cửa sổ để tạo ra một KTable chứa thông tin hàng tồn kho đã được chuẩn hóa và làm phong phú. Các framework xử lý stream giúp dễ dàng xử lý các luồng sự kiện, xây dựng trạng thái nội bộ bằng ECST và kết hợp, ghép dữ liệu từ nhiều sản phẩm dữ liệu khác nhau, chỉ trong vài dòng mã.

Example 1-1. Showcasing joins with Kafka Streams

StreamsBuilderbuilder=newStreamsBuilder();//Materializes the tables from the source Kafka topicsKTableproducts=builder.table("products")KTableproductReviews=builder.table("product_reviews")//Join events on the primary key, apply business logic as neededKTableproductsWithReviews=products.join(productReviews,businessLogic(..),...)builder.build();

Apache Flink có thể cung cấp một cái gì đó tương tự. Giả sử chúng ta muốn một cái gì đó giống như SQL hơn.

Example 1-2. Showcasing joins with Flink SQL

CREATETABLEPRODUCTS(product_idBIGINT,nameVARCHAR,brandVARCHAR,descriptionVARCHAR,timestampTIMESTAMP(3),PRIMARYKEY(product_id)NOTENFORCED,)WITH('connector'='kafka','topic'='products','format'='protobuf','properties.bootstrap.servers'='localhost:9092','properties.group.id'='foobar');CREATETABLEPRODUCT_REVIEWS(product_idBIGINT,reviewsVARCHAR,timestampTIMESTAMP(3),PRIMARYKEY(product_id)NOTENFORCED,)WITH('connector'='kafka','topic'='product_reviews','format'='protobuf','properties.bootstrap.servers'='localhost:9092','properties.group.id'='foobar');CREATETABLEPRODUCTS_WITH_REVIEWSASSELECT*FROMPRODUCTSINNERJOINPRODUCT_REVIEWSONPRODUCTS.product_id=PRODUCT_REVIEWS.product_id;

Cả hai mẫu mã Flink SQL và Kafka Streams đều đơn giản, rõ ràng và ngắn gọn. Chúng tôi sẽ đề cập đến việc xây dựng microservices với những công nghệ này sau trong cuốn sách này. Nhưng hiện tại, khi chúng ta xem xét kiến trúc Lambda, hãy nhớ rằng việc tận dụng kiến trúc Kappa thật dễ dàng. Chỉ cần vài dòng mã để chuyển đổi một luồng sự kiện thành một bảng tự cập nhật, có khả năng điều khiển mã microservice của bạn.

The Lambda Architecture

Kiến trúc Lambda dựa trên cả luồng sự kiện cho dữ liệu thời gian thực và một kho lưu trữ thứ cấp cho dữ liệu lịch sử. Kiến trúc Lambda được xây dựng trên khái niệm lỗi thời rằng bạn không thể lưu trữ sự kiện trong một luồng sự kiện vô thời hạn. Tuy nhiên, nó nhất quán với các công nghệ lỗi thời đã buộc phải đặt thời gian sống (TTL) trên các luồng sự kiện. Nó vẫn tiếp tục bướng bỉnh tồn tại trong tâm trí của nhiều người, vì vậy chúng tôi đưa nó vào cuốn sách này vì mục đích bối cảnh lịch sử, nhưng không phải là sự ủng hộ cho việc sử dụng.

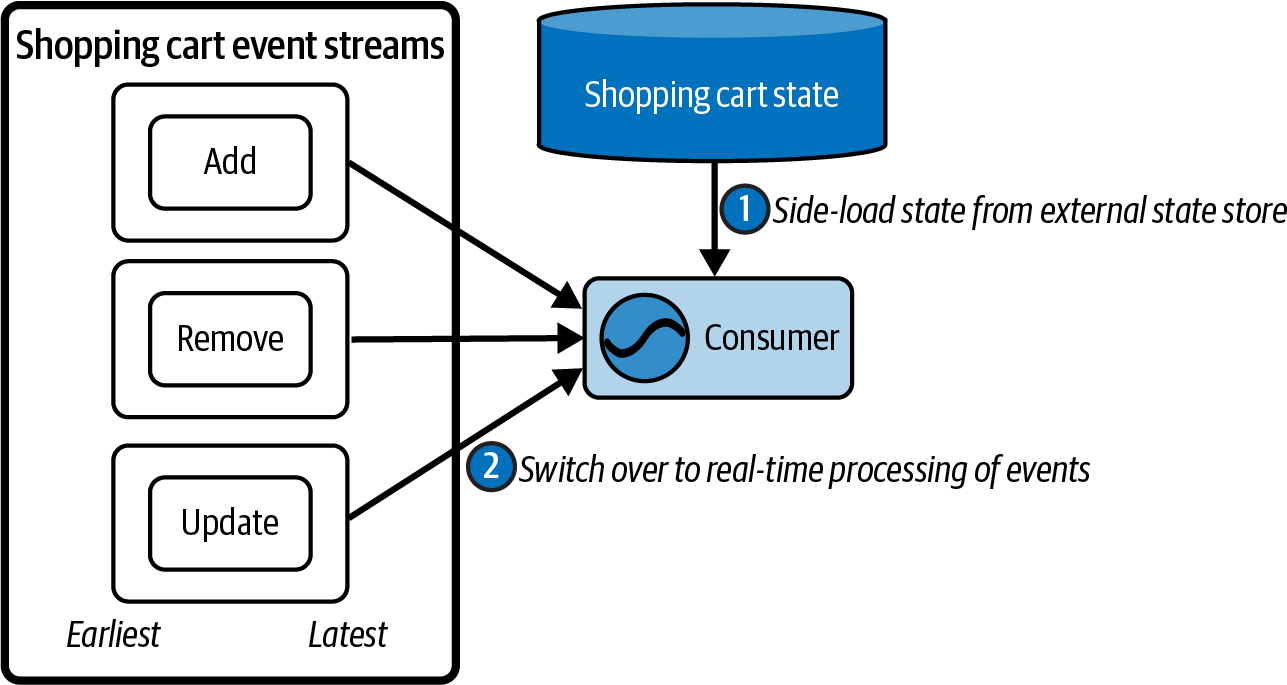

Người tiêu dùng trong kiến trúc lambda phải lấy dữ liệu lịch sử từ kho lưu trữ lịch sử trước tiên, sau đó nạp nó vào các kho trạng thái tương ứng của họ. Sau đó, người tiêu dùng phải chuyển sang luồng sự kiện để nhận các cập nhật và thay đổi tiếp theo.

Có hai phiên bản chính của kiến trúc này. Trong phiên bản đầu tiên, kho dữ liệu lịch sử và luồng được xây dựng độc lập. Trong phiên bản thứ hai, kho dữ liệu lịch sử được xây dựng từ luồng. Hãy xem xét phiên bản đầu tiên trước.

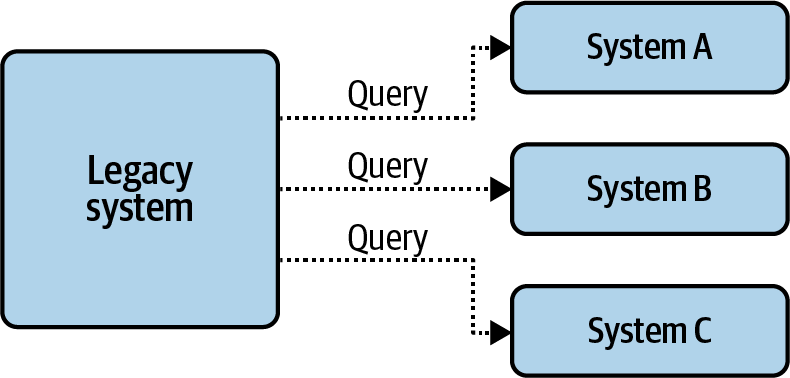

Kho lưu trữ lịch sử chứa kết quả của các tập hợp, vật chất hóa, hoặc các phép tính phong phú hơn. Nó không chỉ là một vị trí khác để lưu trữ sự kiện. Nhìn từ góc độ lịch sử, kho lưu trữ lịch sử thường chỉ là cơ sở dữ liệu nội bộ của hệ thống nguồn. Nói cách khác, bạn sẽ yêu cầu hệ thống nguồn cung cấp dữ liệu lịch sử, tải nó vào hệ thống của bạn, sau đó chuyển sang luồng sự kiện. Điều này là một hình mẫu phản tác dụng vì nó đặt toàn bộ tải đầu cuối lên dịch vụ sản xuất, nhưng nó đủ phổ biến để đáng được đề cập.

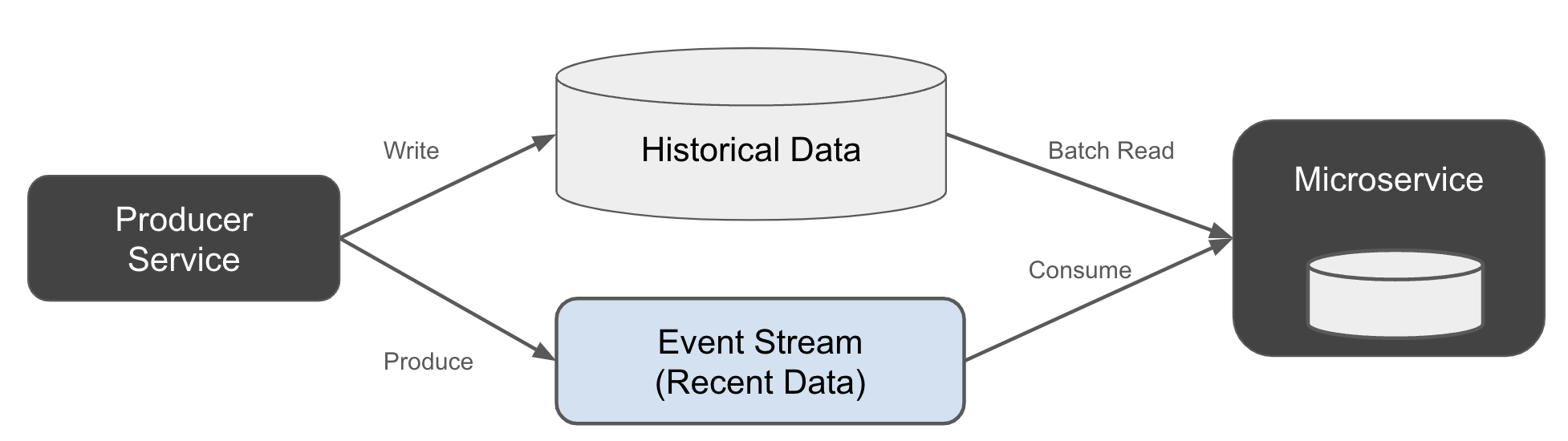

"[Link to Come] cho thấy một cách triển khai đơn giản của kiến trúc Lambda. Nhà sản xuất ghi dữ liệu mới vào cả luồng sự kiện và kho dữ liệu lịch sử."

Figure 1-17. Lambda architecture, writing to both the stream and the historical data table at the same time

Một lỗi lớn trong kế hoạch này là dữ liệu không được ghi một cách nguyên tử. Thực tế là rất khó để đạt được hiệu suất cao cho các giao dịch phân tán trên nhiều hệ thống độc lập. Điều thường xảy ra trong thực tế là nhà sản xuất cập nhật một hệ thống trước (có thể là kho dữ liệu lịch sử), sau đó là hệ thống khác (dòng sự kiện). Một lỗi tạm thời trong quá trình ghi có thể khiến sự kiện được ghi vào kho dữ liệu lịch sử nhưng không vào dòng sự kiện - hoặc ngược lại, tùy thuộc vào mã của bạn.

Vấn đề là dữ liệu luồng và tập dữ liệu lịch sử của bạn sẽ phân kỳ, có nghĩa là bạn sẽ có kết quả khác biệt nếu xây dựng từ luồng so với việc bạn xây dựng từ dữ liệu lịch sử. Một người tiêu dùng cũ chỉ đọc từ luồng có thể tính toán ra một kết quả khác với một người tiêu dùng mới khởi động từ dữ liệu lịch sử. Điều này có thể gây ra những vấn đề nghiêm trọng trong tổ chức của bạn, và nó có thể rất khó để tìm ra lý do tại sao - đặc biệt là vì dữ liệu luồng sự kiện có giới hạn về thời gian, và bằng chứng về sự phân kỳ của nó sẽ bị xóa sau chỉ vài ngày.

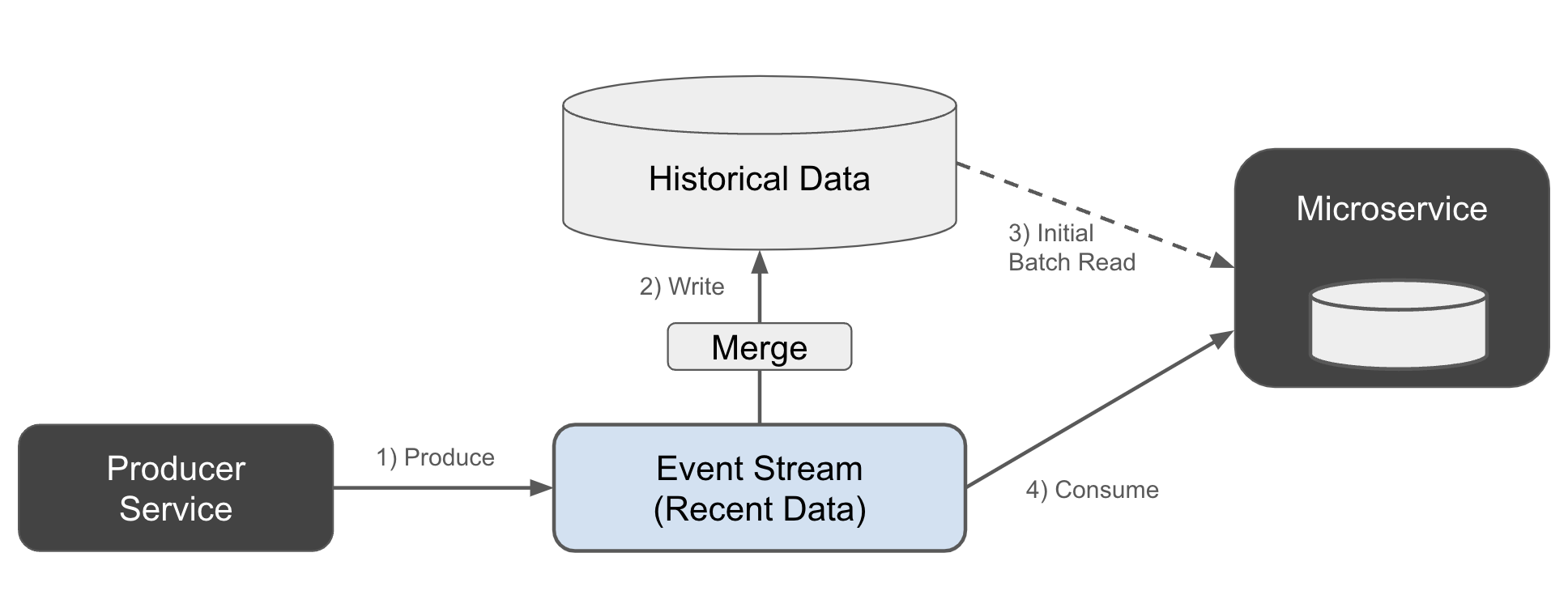

Trong phiên bản thứ hai của kiến trúc Lambda, dữ liệu lịch sử được nạp trực tiếp từ luồng sự kiện ban đầu, như được trình bày trong Hình 1-18.

Figure 1-18. Historical lambda data build from the event stream

Nhà sản xuất ghi trực tiếp vào luồng sự kiện (1). Dữ liệu lịch sử được bổ sung bởi một quy trình thứ cấp kết hợp nó vào kho dữ liệu (2). Người tiêu dùng lần lượt đọc dữ liệu lịch sử trước (3), sau đó chuyển sang luồng sự kiện (4).

Nếu bạn nheo mắt một chút, bạn có thể thấy rằng phiên bản thứ hai này trông giống hệt như kiến trúc Kappa - ngoại trừ việc chúng tôi xây dựng kho trạng thái bên ngoài dịch vụ vi mô. Sự phức tạp duy nhất là chúng tôi đã giới thiệu một sự phân tách awkward giữa nhà môi giới sự kiện và kho dữ liệu lịch sử - một sản phẩm do quan niệm không còn hợp lệ rằng nhà môi giới sự kiện không thể lưu trữ sự kiện một cách vô thời hạn.

Nhìn chung, kiến trúc Lambda có vẻ đơn giản trong lý thuyết, nhưng thực tế lại rất khó để thực hiện tốt. Tại sao? Dưới đây là một vài trở ngại chính, khi chúng ta kết thúc phần này:

- The producer must maintain extra code

-

Mã viết vào luồng, và mã viết vào kho lưu trữ lịch sử.

- The consumer must maintain two code paths

-

Một đường dẫn đọc từ kho lưu trữ lịch sử, và một đường dẫn đọc từ luồng. Người tiêu dùng phải viết mã sao cho có thể chuyển đổi giữa hai đường dẫn mà không bỏ lỡ bất kỳ dữ liệu nào hoặc vô tình sao chép dữ liệu. Điều này có thể khá khó khăn trong thực tế, đặc biệt là với các hệ thống phân tán và các sự cố tạm thời.

- Streamed data may not converge to the same results as the historical data

-

Người tiêu dùng có thể không nhận được kết quả hoàn toàn giống nhau khi đọc từ luồng dữ liệu và từ bảng. Nhà sản xuất phải đảm bảo rằng dữ liệu giữa hai nguồn không khác biệt theo thời gian, nhưng điều này rất khó khăn mà không có các cập nhật nguyên tử cho cả luồng và kho dữ liệu lịch sử.

- The stream and historical data models must evolve in sync

-

Dữ liệu không phải là tĩnh. Nếu bạn cần cập nhật định dạng dữ liệu, điều đó sẽ yêu cầu thay đổi mã ở hai nơi - kho lưu trữ lịch sử và luồng.

- Merging multiple Lambda-powered data sets is almost impossible

-

Rất dễ để kết hợp nhiều tập dữ liệu Kappa, như được minh họa trong [Link sẽ đến]. Không có sự chồng chéo giữa các nguồn dữ liệu, vì vậy bạn chỉ cần phát trực tiếp dữ liệu từ luồng sự kiện và nhận được kết quả nhất quán. Tuy nhiên, không có quy định tự nhiên nào giữa luồng và tập dữ liệu lịch sử. Các bản ghi trong luồng sự kiện và dữ liệu lịch sử sẽ chồng chéo lên nhau, và các quy tắc để hợp nhất bản ghi trước vào sau sẽ khác nhau giữa các tập dữ liệu, cũng như các quy tắc để hết hạn các bản ghi từ luồng sự kiện.

Việc hòa giải lưu trữ song song giữa dữ liệu theo luồng và dữ liệu lịch sử là rất khó khăn cho chỉ một tập dữ liệu. Điều này còn khó khăn hơn khi bạn đưa nhiều tập dữ liệu vào, mỗi tập đều có ranh giới dữ liệu luồng/lịch sử riêng biệt.

Tóm lại, kiến trúc Lambda đơn giản là quá khó để quản lý ở bất kỳ quy mô hợp lý nào. Nó đặt toàn bộ gánh nặng truy cập dữ liệu lên phía người tiêu dùng, buộc họ phải hòa giải giữa hai nguồn không chỉ giữa dữ liệu dòng và dữ liệu lịch sử, mà còn giữa dữ liệu dòng và dữ liệu lịch sử của tất cả các tập dữ liệu khác mà họ muốn xử lý. Thay vào đó, dựa vào kiến trúc Kappa với một nguồn dữ liệu dòng duy nhất để cung cấp dữ liệu lịch sử thì dễ hơn rất nhiều, cả về nhận thức lẫn viết mã.

Event Data Definitions and Schemas

Dữ liệu sự kiện đóng vai trò là phương tiện lưu trữ dữ liệu lâu dài và không phụ thuộc vào việc triển khai, cũng như cơ chế giao tiếp giữa các dịch vụ. Do đó, rất quan trọng để cả nhà sản xuất và nhà tiêu thụ sự kiện đều có sự hiểu biết chung về ý nghĩa của dữ liệu. Lý tưởng nhất là, nhà tiêu thụ phải có khả năng diễn giải nội dung và ý nghĩa của một sự kiện mà không cần phải tham khảo với chủ sở hữu của dịch vụ sản xuất. Điều này đòi hỏi một ngôn ngữ chung cho việc giao tiếp giữa nhà sản xuất và nhà tiêu thụ và tương tự như định nghĩa API giữa các dịch vụ yêu cầu - phản hồi đồng bộ.

Sự lựa chọn về sơ đồ như Apache Avro và Protobuf của Google cung cấp hai tính năng mà các dịch vụ vi mô hướng sự kiện sử dụng rất nhiều. Đầu tiên, chúng cung cấp một khung phát triển, nơi một số tập hợp các thay đổi có thể được thực hiện một cách an toàn đối với các sơ đồ mà không yêu cầu các bên tiêu thụ ở phía hạ nguồn phải thay đổi mã. Thứ hai, chúng cũng cung cấp phương tiện để tạo ra các lớp kiểu (nơi có thể áp dụng) để chuyển đổi dữ liệu đã được sơ đồ hóa thành các đối tượng cũ trong ngôn ngữ mà bạn lựa chọn. Điều này làm cho việc tạo ra logic kinh doanh trở nên đơn giản và minh bạch hơn rất nhiều trong việc phát triển các dịch vụ vi mô. [Liên kết sẽ đến sau] sẽ đề cập đến những chủ đề này chi tiết hơn.

Powering Microservices with the Event Broker

Hệ thống môi giới sự kiện phù hợp với các doanh nghiệp quy mô lớn thường tuân theo cùng một mô hình. Nhiều môi giới sự kiện phân tán hoạt động cùng nhau trong một cụm để cung cấp nền tảng cho việc sản xuất và tiêu thụ các luồng sự kiện và hàng đợi. Mô hình này cung cấp một số tính năng thiết yếu cần thiết để vận hành một hệ sinh thái theo sự kiện ở quy mô lớn:

- Scalability

-

Các phiên bản broker sự kiện bổ sung có thể được thêm vào để tăng cường khả năng sản xuất, tiêu thụ và lưu trữ dữ liệu của cụm.

- Durability

-

Dữ liệu sự kiện được sao chép giữa các nút. Điều này cho phép một cụm các nhà môi giới vừa duy trì vừa tiếp tục phục vụ dữ liệu khi một nhà môi giới gặp sự cố.

- High availability

-

Một cụm các nút môi giới sự kiện cho phép các khách hàng kết nối với các nút khác trong trường hợp xảy ra lỗi môi giới. Điều này cho phép các khách hàng duy trì thời gian hoạt động liên tục.

- High-performance

-

Nhiều nút môi giới chia sẻ tải sản xuất và tiêu thụ. Ngoài ra, mỗi nút môi giới phải có hiệu suất cao để có thể xử lý hàng trăm nghìn ghi hoặc đọc mỗi giây.

Mặc dù có nhiều cách khác nhau để dữ liệu sự kiện có thể được lưu trữ, sao chép và truy cập trong hậu trường của một trung gian sự kiện, nhưng chúng đều cung cấp các cơ chế lưu trữ và truy cập tương tự cho khách hàng của mình.

Selecting an Event Broker

Trong khi cuốn sách này sẽ thường xuyên tham khảo Apache Kafka như một ví dụ, còn có những trình trung gian sự kiện khác có thể là lựa chọn phù hợp. Thay vì so sánh trực tiếp các công nghệ, hãy xem xét kỹ lưỡng các yếu tố sau đây khi chọn trình trung gian sự kiện của bạn.

Support tooling

Các công cụ hỗ trợ là rất cần thiết để phát triển hiệu quả các microservices theo sự kiện. Nhiều công cụ trong số này liên quan đến việc triển khai chính broker sự kiện. Một số trong số đó bao gồm:

-

Duyệt các bản ghi sự kiện luồng

-

Duyệt dữ liệu sơ đồ

-

Hạn ngạch, kiểm soát truy cập và quản lý chủ đề

-

Giám sát, thông lượng và đo lường độ trễ

Xem [Liên kết sẽ đến] để biết thêm thông tin về các công cụ bạn có thể cần.

Hosted services

Các dịch vụ được lưu trữ cho phép bạn thuê ngoài việc tạo ra và quản lý môi giới sự kiện của mình.

-

Có giải pháp lưu trữ nào không?

-

Bạn sẽ mua giải pháp được lưu trữ hay tự lưu trữ nội bộ?

-

Đại lý lưu trữ có cung cấp giám sát, mở rộng, phục hồi thảm họa, sao chép và triển khai đa khu vực không?

-

Nó có gắn bạn với một nhà cung cấp dịch vụ cụ thể nào không?

-

Có dịch vụ hỗ trợ chuyên nghiệp nào có sẵn không?

Client libraries and processing frameworks

Có nhiều triển khai trình trung gian sự kiện để chọn, mỗi cái có mức độ hỗ trợ khách hàng khác nhau. Điều quan trọng là các ngôn ngữ và công cụ thường được sử dụng của bạn phải hoạt động tốt với các thư viện khách hàng.

-

Các thư viện và framework client có tồn tại trong các ngôn ngữ cần thiết không?

-

Bạn có thể xây dựng các thư viện nếu chúng không tồn tại không?

-

Bạn có đang sử dụng các framework phổ biến hay đang cố gắng tự phát triển của riêng mình?

Community support

Hỗ trợ cộng đồng là một khía cạnh cực kỳ quan trọng trong việc chọn lựa một broker sự kiện. Một dự án mã nguồn mở và miễn phí, chẳng hạn như Apache Kafka, là một ví dụ đặc biệt tốt về một broker sự kiện với sự hỗ trợ cộng đồng lớn.

-

Có hỗ trợ cộng đồng trực tuyến không?

-

Công nghệ đã trưởng thành và sẵn sàng sản xuất chưa?

-

Công nghệ này có được sử dụng phổ biến ở nhiều tổ chức không?

-

Công nghệ có thu hút được nhân viên tiềm năng không?

-

Nhân viên có hào hứng để xây dựng với những công nghệ này không?

Indefinite and tiered storage

Lưu trữ không xác định cho phép bạn lưu trữ các sự kiện mãi mãi, với điều kiện bạn có đủ không gian lưu trữ để làm điều đó. Tùy thuộc vào kích thước của các luồng sự kiện và thời gian lưu giữ (ví dụ: không xác định), có thể tốt hơn nếu lưu trữ các đoạn dữ liệu cũ trong lưu trữ chậm hơn nhưng rẻ hơn.

Lưu trữ phân tầng cung cấp nhiều lớp hiệu suất truy cập, với một đĩa riêng được gán cho bộ môi giới sự kiện hoặc các nút phục vụ dữ liệu cung cấp tầng hiệu suất cao nhất. Các tầng tiếp theo có thể bao gồm các tùy chọn như dịch vụ lưu trữ quy mô lớn riêng biệt (ví dụ: Amazon S3, Google Cloud Storage và Azure Storage).

-

Lưu trữ phân lớp có được hỗ trợ tự động không?

-

Dữ liệu có thể được chuyển vào các bậc thấp hơn hoặc cao hơn dựa trên mức sử dụng không?

-

Dữ liệu có thể được truy xuất một cách liền mạch từ bất kỳ tầng nào mà nó được lưu trữ không?

Summary

Dòng sự kiện cung cấp khả năng truy cập dữ liệu bền bỉ, có thể phát lại và có khả năng mở rộng. Chúng có thể cung cấp một lịch sử đầy đủ của các sự kiện, cho phép người tiêu dùng của bạn đọc bất kỳ dữ liệu nào họ cần thông qua một API duy nhất. Mỗi người tiêu dùng được đảm bảo có một bản sao giống hệt của dữ liệu, với điều kiện họ đọc dòng sự kiện như nó đã được ghi lại.

Môi giới sự kiện của bạn là phần cốt lõi của kiến trúc dựa trên sự kiện. Nó chịu trách nhiệm lưu trữ các luồng sự kiện và cung cấp truy cập nhất quán, hiệu suất cao đến dữ liệu cơ bản. Nó đảm bảo độ bền, khả năng chịu lỗi và khả năng mở rộng, để bạn có thể tập trung vào việc xây dựng các dịch vụ của mình, không phải vật lộn với việc truy cập dữ liệu.

Dịch vụ sản xuất công bố một tập hợp các sự kiện kinh doanh quan trọng, phát sóng dữ liệu qua luồng sự kiện đến các dịch vụ tiêu dùng đã đăng ký. Nhà sản xuất không còn chịu trách nhiệm cho các nhu cầu truy vấn đa dạng của tất cả các dịch vụ khác trong tổ chức.

Người tiêu dùng không truy vấn dịch vụ sản xuất để lấy dữ liệu, loại bỏ các kết nối điểm-điểm không cần thiết khỏi kiến trúc của bạn. Trước đây, một nhóm có thể đơn giản viết các truy vấn SQL hoặc sử dụng API yêu cầu/đáp ứng để truy cập dữ liệu được lưu trữ trong cơ sở dữ liệu của một monolith. Trong kiến trúc hướng sự kiện, họ thay vào đó truy cập dữ liệu đó từ một luồng sự kiện, hiện thực hóa và tổng hợp trạng thái của riêng mình cho các nhu cầu kinh doanh của mình.

Việc áp dụng các vi dịch vụ theo sự kiện cho phép tạo ra các dịch vụ chỉ sử dụng trung gian sự kiện để lưu trữ và truy cập dữ liệu. Mặc dù các bản sao cục bộ của sự kiện có thể được sử dụng bởi logic kinh doanh của vi dịch vụ, nhưng trung gian sự kiện vẫn là nguồn thông tin chính duy nhất cho tất cả dữ liệu.

Chapter 2. Fundamentals of Event-Driven Microservices

Một microservice dựa trên sự kiện, như đã giới thiệu trong [Liên kết sẽ đến], là một ứng dụng như bao ứng dụng khác. Nó yêu cầu cùng một loại tài nguyên máy tính, lưu trữ và mạng như bất kỳ ứng dụng nào khác. Nó cũng cần một nơi để lưu trữ mã nguồn, công cụ để xây dựng và triển khai ứng dụng, và giám sát cũng như ghi nhật ký để đảm bảo hoạt động khỏe mạnh. Là một ứng dụng dựa trên sự kiện, nó đọc các sự kiện từ một luồng (hoặc nhiều luồng), thực hiện công việc dựa trên những sự kiện đó, và sau đó xuất ra kết quả - dưới dạng các sự kiện mới, các cuộc gọi API, hoặc các hình thức công việc khác.

`[Liên kết sẽ có] đã giới thiệu ngắn gọn các lợi ích chính của microservices dựa trên sự kiện. Trong chương này, chúng ta sẽ đề cập đến các nguyên tắc cơ bản của microservices dựa trên sự kiện, khám phá vai trò và trách nhiệm của chúng, cùng với các yêu cầu, quy tắc và khuyến nghị để xây dựng các ứng dụng khoẻ mạnh.`

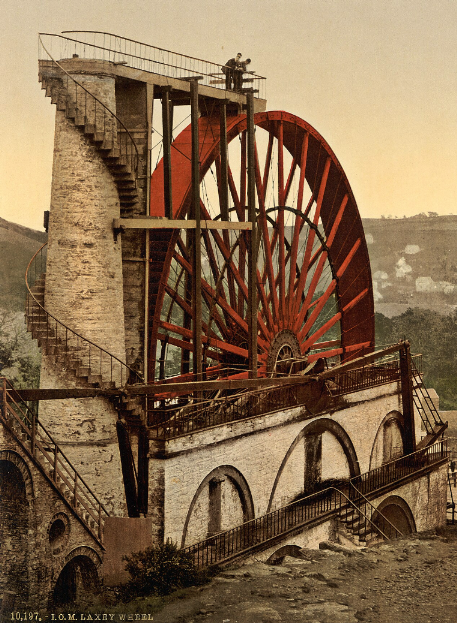

The Basics

Tình huống điều khiển sự kiện có nghĩa là các sự kiện điều khiển logic kinh doanh, giống như nước từ một con suối quay bánh xe nước của một nhà máy (Hình 2-1). Các ứng dụng điều khiển sự kiện, dù lớn hay nhỏ, thường chỉ làm việc khi có các sự kiện xảy ra (hoặc khi một bộ đếm thời gian hết hạn - cũng là một sự kiện). Nếu không, chúng sẽ đứng yên cho đến khi có các sự kiện mới để xử lý.

Figure 2-1. The water stream powers the wheel, as event streams power the microservice Source - wikimedia

Dịch vụ microservice tiêu dùng đọc các sự kiện từ luồng. Mỗi người tiêu dùng có trách nhiệm cập nhật các con trỏ của riêng mình đến các chỉ số đã đọc trước đó trong luồng sự kiện. Chỉ số này, được gọi là offset, là thước đo của sự kiện hiện tại từ đầu luồng sự kiện. Các offset cho phép nhiều người tiêu dùng tiêu thụ và theo dõi tiến trình của họ một cách độc lập với nhau, như được thể hiện trong Hình 2-2.

Figure 2-2. Consumer groups and their per-partition offsets

Nhóm người tiêu dùng cho phép nhiều người tiêu dùng được xem như một thực thể logic duy nhất và có thể được tận dụng để mở rộng quy mô ngang của việc tiêu thụ tin nhắn. Khi một phiên bản người tiêu dùng mới tham gia vào một nhóm người tiêu dùng, các phân vùng thường được tự động phân phối lại giữa các phiên bản đang hoạt động. Điều này cân bằng tải của các sự kiện đến giữa các người tiêu dùng đang hoạt động. Trạng thái, đặc biệt là trạng thái cục bộ, có thể làm cho việc phân bổ lại này trở nên khó khăn hơn, nhưng điều này sẽ được thảo luận thêm trong [Link to Come].

“Vậy điều gì cấu thành nên một microservice dựa trên sự kiện?” bạn có thể hỏi. Có lẽ điều tốt nhất là chỉ cần xem qua một vài ví dụ trước, và làm việc ngược lại từ đó. Hãy cùng xem xét một vài ví dụ về việc triển khai microservice.

The Basic Producer/Consumer

Ví dụ này được đặt tên là "nhà sản xuất / người tiêu dùng cơ bản" vì đó thực sự chỉ là như vậy - nhà sản xuất tạo ra các sự kiện, người tiêu dùng tiêu thụ các sự kiện, và bạn, nhà phát triển phần mềm, phải viết tất cả các hoạt động để kết nối logic kinh doanh. Chúng ta sẽ đi sâu vào mẫu này trong chương [Liên kết sẽ đến], nhưng bây giờ chúng ta sẽ bắt đầu với một ví dụ microservice Python cơ bản.

Dịch vụ này tiêu thụ các sự kiện từ một trình môi giới sự kiện Kafka (tên chủ đề là "input_topic", tổng hợp một tổng và phát ra tổng đã cập nhật tới một luồng sự kiện mới nếu giá trị vượt quá 1000.

Ứng dụng python tạo ra KafkaConsumer (1) và KafkaProducer (2). KafkaConsumer được đặt tên chính xác sẽ đọc các sự kiện từ chủ đề được chỉ định, chuyển đổi các sự kiện từ byte đã được tuần tự hóa thành các đối tượng mà ứng dụng hiểu - trong trường hợp này là khóa văn bản thuần và giá trị JSON. Để làm mới về các khóa và giá trị, bạn có thể nhìn lại “Cấu trúc của một sự kiện”.

fromkafkaimportKafkaConsumer,KafkaProducerimportjsonimporttime# 1) Initialize Kafka consumerconsumer=KafkaConsumer('input_topic_name',bootstrap_servers=['localhost:9092'],value_deserializer=lambdax:json.loads(x.decode('utf-8')),key_deserializer=lambdax:x.decode('utf-8'),group_id='ch03_python_example_consumer_group_name',auto_offset_reset='earliest')# 2) Initialize Kafka producerproducer=KafkaProducer(bootstrap_servers=['localhost:9092'],value_serializer=lambdax:json.dumps(x).encode('utf-8'),key_serializer=lambdax:x.encode('utf-8'))# 3) Connect to the state store (A simple dictionary to keep track of the sums per key)key_sums={}# 4) Polling loopwhileTrue:# 5 Poll for new eventsevent_batch=consumer.poll(timeout_ms=1000)# 6 Process each partition's eventsforpartition_batchinevent_batch.values():foreventinpartition_batch:key=event.keynumber=event.value['number']# 7) Update sum for this keyifkeynotinkey_sums:key_sums[key]=0key_sums[key]+=number# 8) Check if sum exceeds 1000ifkey_sums[key]>1000:# Prepare and send new eventoutput_event={'key':key,'total_sum':key_sums[key]}# 9) Write to topic named "key_sums"producer.send('key_sums',key=key,value=output_event)# 10) Flushes the events to the brokerproducer.flush()

Tiếp theo, mã sẽ tạo ra một kho trạng thái đơn giản (3). Bạn sẽ có khả năng cao muốn sử dụng một cái gì đó khác ngoài từ điển trong bộ nhớ, nhưng đây là một ví dụ đơn giản và bạn có thể thay thế nó bằng một RDBMS, một kho khóa-giá trị được quản lý hoàn toàn, hoặc một kho trạng thái bền bỉ khác.

Tip

Chọn kho trạng thái phù hợp nhất với trường hợp sử dụng của vi dịch vụ của bạn. Một số trường hợp sẽ được phục vụ tốt nhất bằng các kho lưu trữ khóa-giá trị hiệu suất cao, trong khi những trường hợp khác sẽ được phục vụ tốt hơn thông qua RDBMS, đồ thị hoặc tài liệu, chẳng hạn.

Bước thứ tư là vào một vòng lặp vô hạn (4) để lấy dữ liệu từ chủ đề đầu vào cho một lô sự kiện (5) và xử lý mỗi sự kiện trên cơ sở từng phân vùng (6). Đối với mỗi sự kiện, logic kinh doanh cập nhật tổng khóa (7), và nếu nó > 1000 (8), thì nó tạo ra một sự kiện với tổng để viết vào chủ đề đầu ra key_sums (9 và 10).

Đây là một ứng dụng rất đơn giản. Nhưng nó thể hiện các thành phần chính phổ biến trong phần lớn các dịch vụ vi mô dựa trên sự kiện: người tiêu dùng dòng sự kiện, nhà sản xuất, kho trạng thái và một vòng lặp xử lý liên tục được điều khiển bởi sự xuất hiện của các sự kiện mới trên các dòng đầu vào. Logic kinh doanh được nhúng trong vòng lặp xử lý, và mặc dù ví dụ này rất đơn giản, vẫn có nhiều hoạt động mạnh mẽ và phức tạp hơn mà chúng ta có thể thực hiện.

Hãy cùng xem thêm một vài ví dụ nữa.

The Stream-Processing Event-Driven Application

Ứng dụng xử lý sự kiện theo dòng được xây dựng bằng cách sử dụng một khung xử lý theo dòng. Một số ví dụ phổ biến bao gồm Apache Kafka Streams, Apache Flink, Apache Spark và Akka Streams. Một số ví dụ cũ mà tôi đã đề cập trong ấn bản đầu tiên không còn phổ biến nữa, nhưng đã bao gồm Apache Storm và Apache Samza.

Các khung phát trực tuyến cung cấp sự tích hợp chặt chẽ hơn với môi trường quản lý sự kiện và giảm bớt khối lượng công việc mà bạn phải đối mặt khi xây dựng EDM của mình. Ngoài ra, chúng thường cung cấp các tính toán mạnh mẽ hơn với các cấu trúc cấp cao hơn, chẳng hạn như cho phép bạn kết hợp các luồng và bảng vật liệu với rất ít nỗ lực từ phía bạn.

Một điểm khác biệt chính của các khung xử lý luồng so với mô hình sản xuất/tiêu thụ cơ bản là các bộ xử lý luồng yêu cầu hoặc một cụm độc lập riêng (như trong trường hợp của Flink và Spark), hoặc một sự tích hợp chặt chẽ với một trung gian sự kiện cụ thể (như trong trường hợp của Kafka Streams).

Flink và Spark (cùng với những cái khác như vậy) sử dụng các cụm xử lý độc quyền của riêng chúng để quản lý trạng thái, khả năng mở rộng, độ bền và định tuyến dữ liệu bên trong. Ngược lại, Kafka Streams chỉ dựa vào cụm Kafka để lưu trữ trạng thái bền vững của riêng nó, cung cấp khả năng tái phân vùng chủ đề và chức năng mở rộng ứng dụng.

Các chương tương lai (nhẹ, nặng) sẽ đề cập đến cả hai loại khung này một cách chi tiết hơn. Bây giờ, chúng ta hãy chuyển sang một ví dụ thực tiễn (và kết hợp) sử dụng Apache Flink.

// 1) TableEnvironment manages access and usage of the tables in the Flink applicationTableEnvironmenttableEnv=TableEnvironment.create(EnvironmentSettings.inStreamingMode());// 2) Create the output table for joined results, connecting to a Kafka broker.tableEnv.executeSql("CREATE TABLE PurchasesInnerJoinOrders ("+" order_id STRING,"+" /* Add all columns you want to output here */"+") WITH ("+" 'connector' = 'kafka',"+" 'topic' = 'PurchasesInnerJoinOrders',"+" 'properties.bootstrap.servers' = 'localhost:9092',"")");//Other table definitions removed for brevity. They are very similar.// 3) Reference the Sales and Purchase tables (assumes they are already created as tables in the catalog)Tablesales=tableEnv.from("Sales");Tablepurchases=tableEnv.from("Purchase");// 4) Perform inner join between Sales and Purchase tables on order_idTableresult=sales.join(purchases).where($("Sales.order_id").isEqual($("Purchase.order_id")));// 5) Insert the joined results into the output Kafka topicresult.executeInsert("PurchasesInnerJoinOrders");

Đây là một ứng dụng khá ngắn gọn, nhưng nó chứa đựng nhiều sức mạnh. Đầu tiên (1), chúng ta tạo kết nối tableEnv để quản lý công việc trong môi trường bảng của chúng ta. Tiếp theo, chúng ta khai báo bảng đầu ra (2), được kết nối với chủ đề Kafka PurchasesInnerJoinOrders. Bạn chỉ cần tạo điều này một lần. Tôi đã bỏ qua các khai báo khác để tiết kiệm thời gian.

Thứ ba (3), bạn tạo ra các tham chiếu đến bảng Bán hàng và Mua hàng để có thể sử dụng chúng trong ứng dụng của bạn. Những bảng này là dòng dữ liệu vật chất, như đã đề cập trong “Vật chất hóa trạng thái từ các sự kiện thực thể”.

Thứ tư (4), mã khai báo các biến đổi cần thực hiện trên các sự kiện làm đầy các bảng vật liệu. Một vài dòng này thực hiện nhiều công việc quan trọng. Không chỉ thực hiện các thao tác kết hợp hai bảng này với nhau, mà nó còn xử lý tính năng chống lỗi, cân bằng tải, xử lý theo thứ tự và tải dữ liệu lớn. Nó cũng dễ dàng kết hợp các luồng và bảng đã được phân vùng và định khóa hoàn toàn khác nhau, điều mà bạn có thể sẽ gặp phải.

Cuối cùng, ứng dụng ghi dữ liệu vào bảng đầu ra. Các cơ chế của framework streaming Flink sẽ xử lý phần còn lại để cam kết dữ liệu vào chủ đề Kafka.

Các khung phát trực tuyến cung cấp khả năng rất mạnh mẽ, nhưng thường đòi hỏi một khoản đầu tư ban đầu lớn hơn vào kiến trúc hỗ trợ. Chúng thường chỉ cung cấp hỗ trợ giới hạn cho các ngôn ngữ (Python và JVM là phổ biến nhất), mặc dù đã có một số tiến bộ trong việc hỗ trợ các ngôn ngữ khác kể từ khi phiên bản đầu tiên của cuốn sách này được xuất bản. Trên thực tế, các ngôn ngữ SQL (hoặc ngôn ngữ tương tự SQL) có thể là nhóm phát triển nhanh nhất. Hãy cùng xem xét những điều đó tiếp theo.

The “Streaming SQL” Query

“Liệu microservice của bạn có nên chỉ là một truy vấn SQL không?”

Đó là một câu hỏi hay, đặc biệt là với sự gia tăng của các dịch vụ quản lý SQL streaming. Chính những điều khiến SQL trở nên phổ biến trong thế giới cơ sở dữ liệu cũng làm cho nó được ưa chuộng trong thế giới streaming. Bản chất khai báo của nó có nghĩa là bạn chỉ cần khai báo kết quả mà bạn đang tìm kiếm. Bạn không cần phải chỉ định cách để thực hiện điều đó, vì đó là nhiệm vụ của động cơ xử lý bên dưới.

Ngoài ra, SQL cho phép bạn viết những câu lệnh rất rõ ràng và súc tích về những gì bạn muốn làm với dữ liệu của mình - trong trường hợp này, là luồng sự kiện. Dưới đây là một ví dụ về cùng một ứng dụng Flink, nhưng được viết bằng Flink SQL.

--Assumes we have already declares the materialized input tables and the output tableINSERTINTOPurchasesInnerJoinOrdersSELECT*FROMSalessINNERJOINPurchasepONs.order_id=p.order_id;

Đó là tất cả. Đơn giản nhưng mạnh mẽ. Truy vấn SQL Streaming này sẽ chạy mãi mãi, hoạt động như một microservice độc lập.

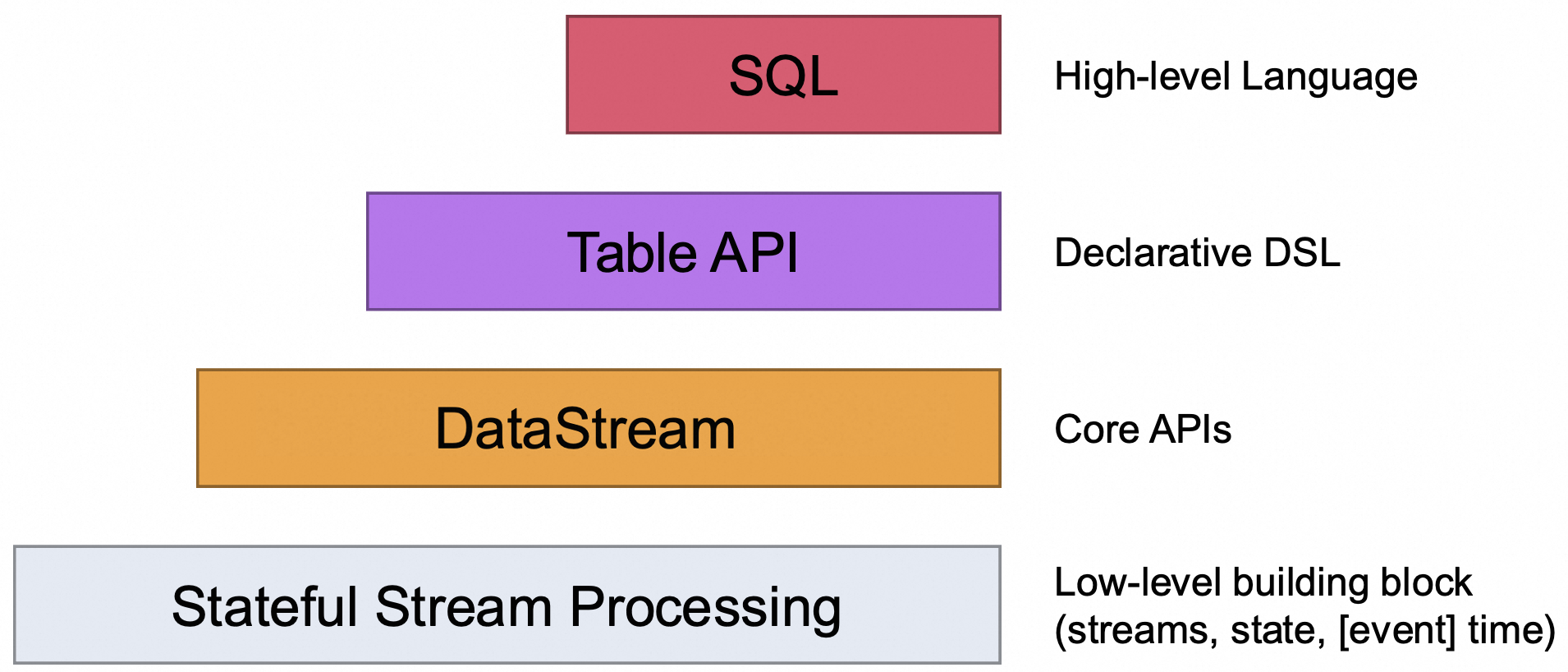

SQL luồng hiện chưa được chuẩn hóa. Có nhiều loại và hình thức khác nhau, vì vậy bạn sẽ phải tự mình nghiên cứu để tìm hiểu điều gì được hỗ trợ và điều gì không được hỗ trợ theo từng khung luồng. Thêm vào đó, SQL luồng thường yêu cầu một bộ API cấp thấp mạnh mẽ để hoạt động ngoài những ví dụ đơn giản. Dự án Flink, chẳng hạn như trong Hình 2-3, có nhiều lớp API, mỗi lớp phụ thuộc vào những lớp bên dưới nó.

Figure 2-3. The four levels of Flink APIs - Source - apache.org

Nói tóm lại, hãy chú ý đến các cơ hội sử dụng SQL trong các microservices của bạn. Nó có thể giúp bạn tiết kiệm rất nhiều thời gian và công sức, và cho phép bạn tiếp tục với các công việc khác. Chúng ta sẽ xem xét SQL theo luồng chi tiết hơn một chút trong [Liên kết sẽ đến].

The Legacy Application

Các ứng dụng kế thừa thường không được viết với tư duy xử lý theo sự kiện. Chúng thường là những hệ thống cũ nhưng quan trọng, phục vụ cho các chức năng kinh doanh quan trọng, nhưng không còn được phát triển tích cực nữa. Các thay đổi đối với những dịch vụ này rất hiếm, và chỉ được thực hiện khi cần thiết tuyệt đối. Chúng cũng thường là những người giám sát dữ liệu kinh doanh quan trọng, được lưu trữ riêng biệt trong cơ sở dữ liệu hoặc kho tệp của hệ thống.

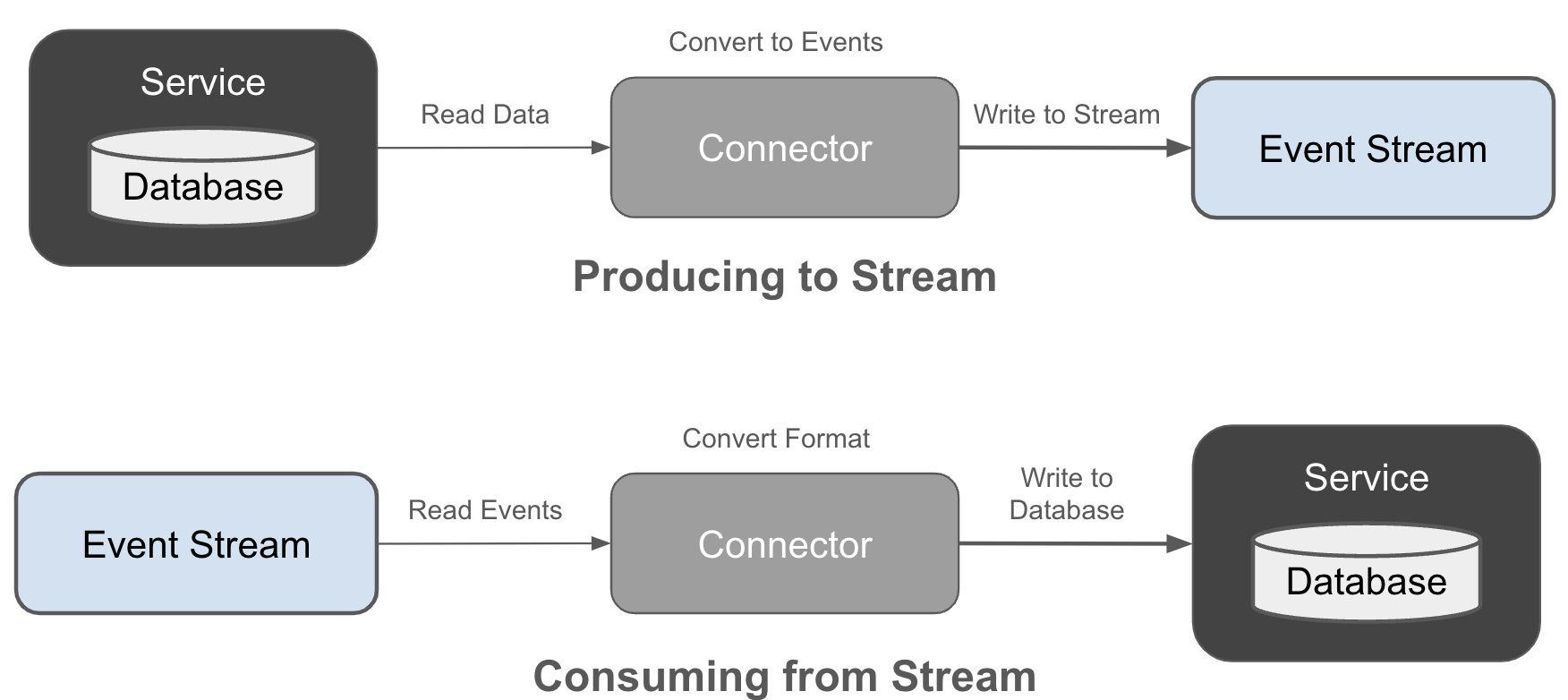

Ứng dụng kế thừa về cơ bản là một cấu trúc cứng nhắc mà bạn khó có thể thay đổi. Nhưng bạn vẫn có thể tích hợp nó vào kiến trúc sự kiện tổng thể của mình thông qua việc sử dụng các bộ kết nối, như được mô tả trong Hình 2-4.

Figure 2-4. Producing and consuming event streams with connectors

Các connector có thể đọc sự kiện từ một hệ thống hoặc cơ sở dữ liệu nguồn, chuyển đổi dữ liệu thành sự kiện, và ghi chúng vào một luồng sự kiện. Tương tự, các connector cũng có thể đọc sự kiện từ một luồng, chuyển đổi chúng thành định dạng phù hợp, và ghi chúng vào API hoặc cơ sở dữ liệu của hệ thống kế thừa. Chúng cung cấp phương tiện để tích hợp những ứng dụng hiện có vào kiến trúc hướng sự kiện của bạn mà không cần phải thiết kế lại toàn bộ hệ thống như một kiến trúc hướng sự kiện nguyên bản.

Các kết nối cho phép bạn bắt đầu với các luồng sự kiện mà không cần phải tạo lại toàn bộ kiến trúc của mình. Chúng giúp bạn dễ dàng đưa dữ liệu vào các luồng, để bạn có thể bắt đầu nhận giá trị từ các microservices theo sự kiện của mình trong thời gian sớm nhất có thể. Chúng tôi sẽ trình bày chi tiết về các kết nối trong [Link to Come].

Bây giờ, bốn dịch vụ này có thể cần phải làm việc cùng nhau. Khác với một dịch vụ macro duy nhất (ví dụ: một khối đơn), microservices theo định nghĩa là một tập hợp các dịch vụ phụ thuộc vào nhau. Mặc dù chúng ta cố gắng đạt được sự tách biệt và giao tiếp bất đồng bộ, nhưng vào cuối ngày, mỗi dịch vụ này có thể (và thường là) phụ thuộc vào công việc được thực hiện bởi các dịch vụ khác. Do đó, chúng ta có một loại mối quan hệ mạng... chuyển sang Trách nhiệm.

Event-Driven Microservice Responsibilities

- Service Boundaries and Scope

-

Một tập hợp ranh giới được xác định rõ ràng. Ứng dụng này chịu trách nhiệm về điều gì? Và nó không chịu trách nhiệm về điều gì? Điều sau trở nên quan trọng hơn khi bạn có nhiều microservices hoạt động cùng nhau để hoàn thành một quy trình phức tạp hơn, nơi có thể hơi khó phân biệt trách nhiệm của mỗi dịch vụ. Bằng cách ánh xạ các microservices một cách sạch sẽ nhất có thể đến các bối cảnh ranh giới, chúng ta có thể tránh được nhiều sự suy đoán và mơ hồ có thể phát sinh.

- Scalability

-

Microservice có trách nhiệm đảm bảo rằng nó có khả năng mở rộng. Cụ thể, nó phải được viết theo cách cho phép nó mở rộng theo chiều ngang (nhiều phiên bản hơn) hoặc theo chiều dọc (phiên bản mạnh mẽ hơn), tùy thuộc vào yêu cầu của nó. Các khung EDM cung cấp khả năng mở rộng sẵn có thường có sức hấp dẫn lớn hơn do khả năng mở rộng tích hợp liền mạch. Tuy nhiên, sức mạnh xử lý cơ bản là thứ mà nền tảng microservice cung cấp. Chúng ta sẽ nói về điều đó ở phần cuối của chương này.

- State Management

-

Microservice chỉ chịu trách nhiệm cho việc tạo, đọc, cập nhật và xóa dữ liệu trong kho dữ liệu của nó. Bất kỳ hoạt động nào thay đổi trạng thái trong microservice đều hoàn toàn nằm trong ranh giới kiểm soát của nó. Mọi vấn đề với kho trạng thái, chẳng hạn như hết dung lượng đĩa hoặc không kiểm tra thay đổi ứng dụng cũng thuộc về không gian vấn đề của microservice. [Liên kết sẽ có sau] đi vào chi tiết hơn về cách xây dựng và quản lý trạng thái cho các microservice dựa trên sự kiện.

- Track Stream Input Progress

-

Mỗi microservice phải theo dõi tiến trình của nó trong việc đọc các luồng sự kiện đầu vào. Ví dụ, Apache Kafka theo dõi tiến trình này bằng cách sử dụng một nhóm tiêu thụ, một nhóm cho mỗi microservice logic. Các nhóm tiêu thụ cũng được nhiều broker sự kiện hàng đầu khác sử dụng, mặc dù một tiêu thụ vẫn có thể chọn thao tác thủ công với các offset của chính nó (chẳng hạn như để phát lại một số bản ghi) hoặc lưu chúng ở nơi khác, chẳng hạn như trong kho dữ liệu riêng của mình.

- Failure Recovery

-

Microservices chịu trách nhiệm đảm bảo rằng chúng có thể tự khôi phục trở lại trạng thái khỏe mạnh sau một sự cố. Các framework mà chúng tôi sẽ dựa vào để vận hành microservices thường khá hiệu quả trong việc đưa các dịch vụ chết trở lại hoạt động, nhưng các dịch vụ của chúng tôi sẽ có trách nhiệm khôi phục trạng thái, khôi phục tiến trình luồng sự kiện đầu vào và tiếp tục từ nơi chúng đã dừng lại trước khi xảy ra sự cố.

Ứng dụng cũng phải xem xét trạng thái đã lưu của nó liên quan đến tiến trình đầu vào dòng. Trong trường hợp bị sự cố, dịch vụ tiêu thụ sẽ tiếp tục từ các offset tốt nhất cuối cùng mà nó biết, điều này có thể dẫn đến việc xử lý trùng lặp và cập nhật trạng thái lưu trữ trùng lặp.

- The Single Writer Topic Principle

-

Mỗi luồng sự kiện chỉ có một microservice sản xuất duy nhất. Microservice này là chủ sở hữu của mỗi sự kiện được sản xuất cho luồng đó. Điều này cho phép nguồn gốc chính xác của sự thật luôn được biết đến cho bất kỳ sự kiện nào, bằng cách cho phép theo dõi nguồn gốc dữ liệu qua hệ thống. Các cơ chế kiểm soát truy cập, như đã thảo luận trong [Link to Come], nên được sử dụng để thực thi quyền sở hữu và ranh giới ghi.

- Partitioning and Event Keys

-

Microservice có trách nhiệm chọn khóa chính của bản ghi đầu ra (xem "Cấu trúc của một sự kiện") và cũng có trách nhiệm xác định phân vùng nào để gửi bản ghi đó đến. Các bản ghi có cùng khóa thường đi đến cùng một phân vùng, mặc dù bạn có thể chọn các chiến lược khác (ví dụ: round-robin, ngẫu nhiên hoặc tùy chỉnh). Cuối cùng, microservice của bạn có trách nhiệm chọn phân vùng nào để ghi sự kiện vào.

- Event Schema Definitions and Data Contracts

-

Cũng giống như lựa chọn của microservice của bạn trong việc chọn khóa bản ghi, nó cũng có quyền lựa chọn định dạng schema để ghi lại sự kiện. Ví dụ, bạn viết product_id dưới dạng String? Hay bạn viết nó dưới dạng Integer? Chương [Liên kết sẽ có] sẽ đề cập đến điều này chi tiết hơn, nhưng hiện tại, hãy lập kế hoạch sử dụng một schema Avro, Protobuf hoặc JSON đã được định nghĩa rõ ràng để ghi lại các bản ghi của bạn. Điều này sẽ giúp các luồng sự kiện của bạn dễ sử dụng hơn, cung cấp sự rõ ràng cho người tiêu dùng và tạo ra một hệ sinh thái dựa trên sự kiện khỏe mạnh hơn.

Một microservice cũng nên có kích thước hợp lý. Bạn có thấy điều đó mơ hồ không? Hãy đọc tiếp.

How small should a microservice be?

Đầu tiên, mục tiêu của kiến trúc vi dịch vụ không phải là tạo ra càng nhiều càng tốt. Bạn sẽ không nhận được bất kỳ giải thưởng nào cho việc có số lượng dịch vụ cao nhất, và trải nghiệm đó cũng sẽ không mang lại cho bạn sự thỏa mãn. Thực tế, bạn thậm chí có thể viết một blog về cách bạn đã tạo ra 1000 vi dịch vụ và mọi thứ đều tồi tệ.

Thực tế là mọi dịch vụ bạn xây dựng, dù là vi mô hay khác, đều phát sinh chi phí đi kèm. Tuy nhiên, chúng tôi cũng muốn tránh những đau khổ mà một kiến trúc đơn thể mang lại. Sự cân bằng nằm ở đâu?

Một microservice nên được quản lý bởi một đội duy nhất, và đội đó nên có khả năng để những người khác trong đội làm việc trên dịch vụ khi cần. Đội đó lớn bao nhiêu? Đội hai chiếc pizza là một thước đo phổ biến, mặc dù nó có thể là một hướng dẫn không đáng tin cậy chút nào tùy thuộc vào việc các lập trình viên của bạn đói bao nhiêu.

Một lập trình viên đơn lẻ trong đội này nên có khả năng nắm bắt không gian công việc mà dịch vụ đảm nhận trong đầu của họ. Một lập trình viên mới đến với microservice nên có khả năng tìm hiểu về các nhiệm vụ của dịch vụ đó và cách mà nó thực hiện các nhiệm vụ đó chỉ trong một hoặc hai ngày.

Cuối cùng, mối quan tâm thực sự là dịch vụ phục vụ một bối cảnh giới hạn cụ thể và đáp ứng nhu cầu kinh doanh. Kích thước, hoặc nó thực sự nhỏ như thế nào, trở thành một mối quan tâm thứ yếu. Bạn có thể kết thúc với các microservices vượt quá ranh giới tối đa mà tôi đã quy định ở đây, và điều đó là hoàn toàn chấp nhận được - phần quan trọng là bạn có thể xác định mối quan tâm kinh doanh cụ thể mà nó đáp ứng, các ranh giới của dịch vụ, và có thể duy trì một danh sách tư duy tốt về những gì dịch vụ nên làm và không nên làm.

Dưới đây là một vài mẹo nhanh:

-

Chỉ xây dựng b ст dịch vụ cần thiết. Nhiều hơn không tốt hơn.

-

Mỗi người nên có khả năng hiểu toàn bộ dịch vụ.

-

Đội ngũ của bạn sẽ cần chịu trách nhiệm sở hữu và duy trì dịch vụ cũng như các luồng sự kiện đầu ra.

-

Hãy xem xét việc thêm chức năng vào một dịch vụ hiện có trước. Điều này sẽ giảm bớt chi phí cho mỗi ứng dụng của bạn, như chúng ta sẽ thấy ở phần tiếp theo.

-

Đối với các microservices mà bạn xây dựng, hãy tập trung vào việc phát triển các thành phần mô-đun. Bạn có thể nhận thấy rằng khi doanh nghiệp của bạn phát triển, bạn sẽ cần tách ra một mô-đun để chuyển đổi thành microservice riêng của nó.

Trong phần tiếp theo, chúng ta sẽ xem xét cách quản lý microservices, bao gồm cả cách quản lý chúng khi mở rộng.

Managing Microservices at Scale

Quản lý microservices có thể trở nên ngày càng khó khăn khi số lượng dịch vụ tăng lên. Mỗi microservice yêu cầu các tài nguyên tính toán cụ thể, kho dữ liệu, cấu hình, biến môi trường, và nhiều thuộc tính khác đặc trưng cho microservice. Mỗi microservice cũng phải có thể quản lý và triển khai được bởi đội ngũ sở hữu nó. Việc container hóa và ảo hóa, cùng với các hệ thống quản lý liên quan, là những cách phổ biến để đạt được điều này. Cả hai tùy chọn cho phép các đội ngũ cá nhân tùy chỉnh yêu cầu của microservices thông qua một đơn vị triển khai duy nhất.

Putting Microservices into Containers

Containers, được phổ biến bởi Docker, cách ly các ứng dụng với nhau. Containers tận dụng hệ điều hành máy chủ hiện có thông qua mô hình kernel chia sẻ. Điều này cung cấp sự tách biệt cơ bản giữa các containers, trong khi container tự nó cách ly các biến môi trường, thư viện và các phụ thuộc khác. Containers cung cấp hầu hết các lợi ích của một máy ảo (được trình bày tiếp theo) với chi phí thấp hơn, thời gian khởi động nhanh và mức tiêu thụ tài nguyên thấp.

Cách tiếp cận hệ điều hành chia sẻ của các container có một số đánh đổi. Các ứng dụng đóng gói phải có khả năng chạy trên hệ điều hành của máy chủ. Nếu một ứng dụng yêu cầu một hệ điều hành chuyên biệt, thì cần phải thiết lập một máy chủ độc lập. An ninh là một trong những mối quan tâm chính, vì các container chia sẻ quyền truy cập vào hệ điều hành của máy chủ. Một lỗ hổng trong nhân có thể đặt tất cả các container trên máy chủ đó vào tình trạng rủi ro. Với các khối lượng công việc thân thiện, điều này khó có thể trở thành vấn đề, nhưng các mô hình chia sẻ không gian trong điện toán đám mây hiện tại đang bắt đầu biến nó thành một yếu tố quan trọng hơn.

Putting Microservices into Virtual Machines

Máy ảo (VM) khắc phục một số nhược điểm của container, mặc dù việc áp dụng chúng chậm hơn. VM truyền thống cung cấp sự cô lập hoàn toàn với một hệ điều hành tự chứa và phần cứng ảo hóa được chỉ định cho mỗi phiên bản. Mặc dù lựa chọn này cung cấp bảo mật cao hơn so với container, nhưng từ trước đến nay nó tốn kém hơn nhiều. Mỗi VM có chi phí quản lý cao hơn so với container, với thời gian khởi động chậm hơn và yêu cầu hệ thống lớn hơn.

Tip

Các nỗ lực đang được thực hiện để làm cho máy ảo (VM) rẻ hơn và hiệu quả hơn. Những sáng kiến hiện tại bao gồm gVisor của Google, Firecracker của Amazon và Kata Containers, chỉ đề cập đến một số ví dụ. Khi các công nghệ này được cải tiến, máy ảo sẽ trở thành một phương án cạnh tranh hơn nhiều với các container cho nhu cầu vi dịch vụ của bạn. Đáng để theo dõi lĩnh vực này nếu nhu cầu của bạn do yêu cầu bảo mật hàng đầu.

Managing Containers and Virtual Machines

Các container và máy ảo (VM) được quản lý thông qua nhiều phần mềm chuyên biệt được gọi là hệ thống quản lý container (CMS). Những hệ thống này kiểm soát việc triển khai container, phân bổ tài nguyên và tích hợp với các tài nguyên máy tính cơ bản. Những CMS phổ biến và thường được sử dụng bao gồm Kubernetes, Docker Engine, Mesos Marathon, Amazon ECS và Nomad.

Các microservices phải có khả năng mở rộng lên và xuống tùy thuộc vào khối lượng công việc thay đổi, các thỏa thuận cấp dịch vụ (SLA) và yêu cầu về hiệu suất. Cần hỗ trợ mở rộng theo chiều dọc, trong đó các tài nguyên tính toán như CPU, bộ nhớ và đĩa được tăng hoặc giảm trên mỗi phiên bản microservice. Cũng cần hỗ trợ mở rộng theo chiều ngang, với các phiên bản mới được thêm vào hoặc gỡ bỏ.

Mỗi microservice nên được triển khai như một đơn vị duy nhất. Đối với nhiều microservice, một thực thi đơn lẻ là tất cả những gì cần thiết để thực hiện các yêu cầu kinh doanh của nó, và nó có thể được triển khai trong một container duy nhất. Các microservice khác có thể phức tạp hơn, yêu cầu sự phối hợp giữa nhiều container và các kho dữ liệu bên ngoài. Đây là lúc khái niệm pod của Kubernetes phát huy tác dụng, cho phép nhiều container được triển khai và quay lại như một hành động duy nhất. Kubernetes cũng cho phép thực hiện các thao tác chỉ một lần; ví dụ, các thao tác di chuyển cơ sở dữ liệu có thể được thực hiện trong quá trình thực thi của việc triển khai đơn lẻ.